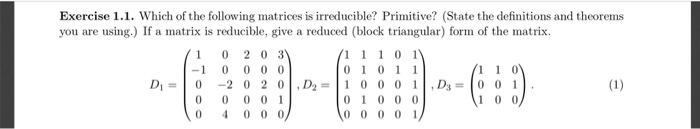

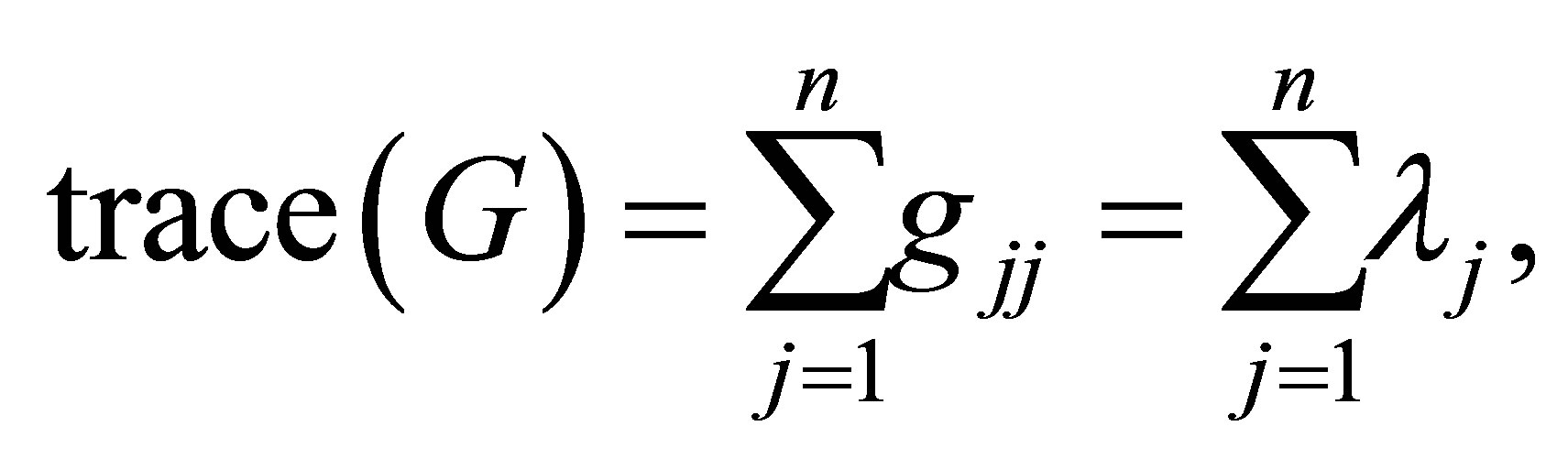

ماتریس تحویل ناپذیر یا تحویل پذیر

10. ردیابی ماتریس های مستطیلی

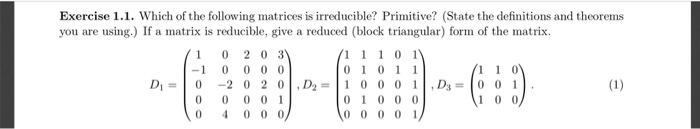

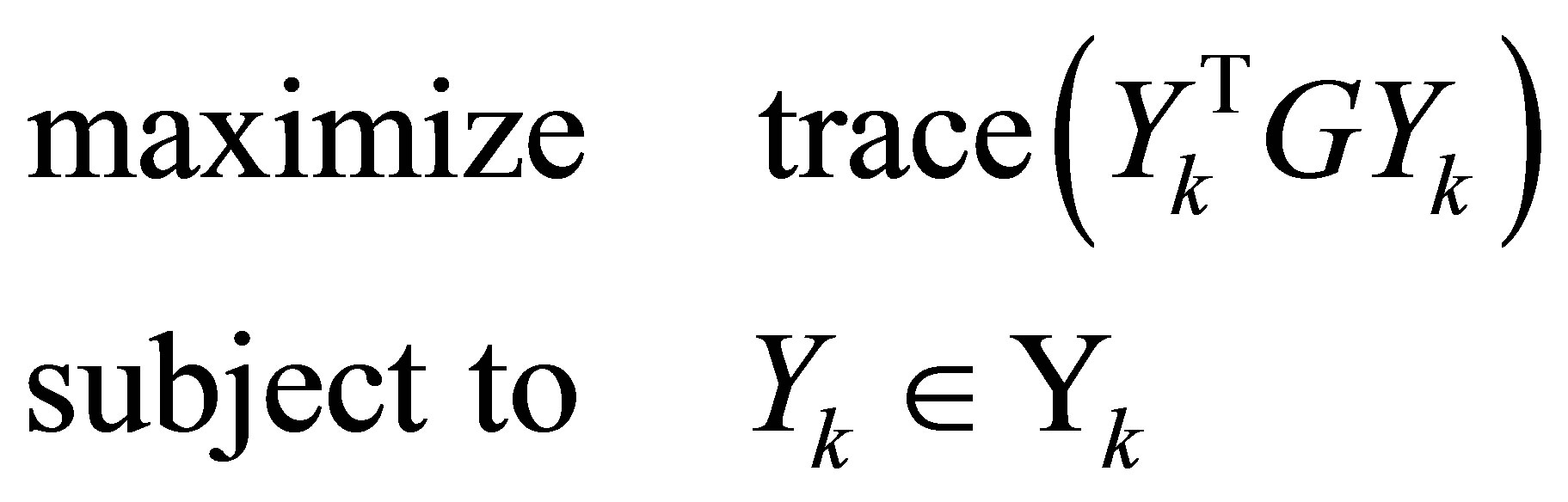

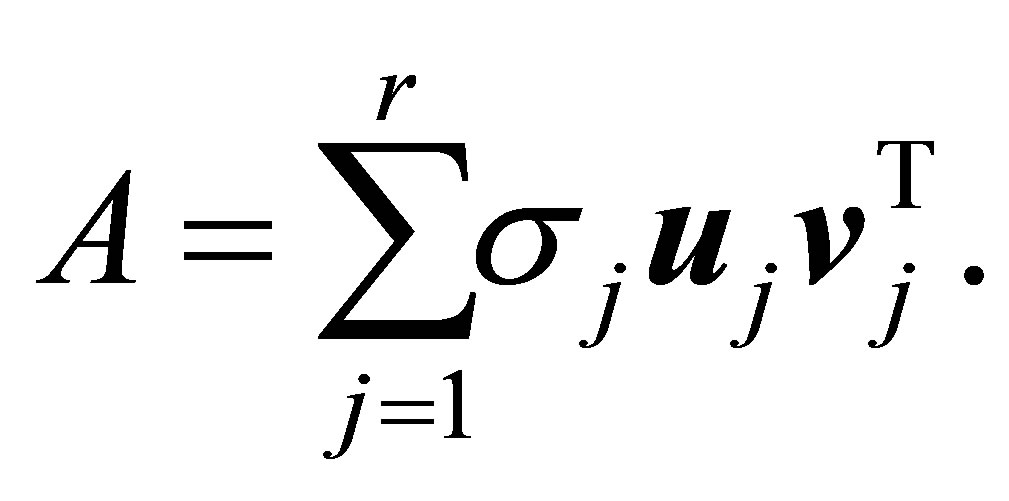

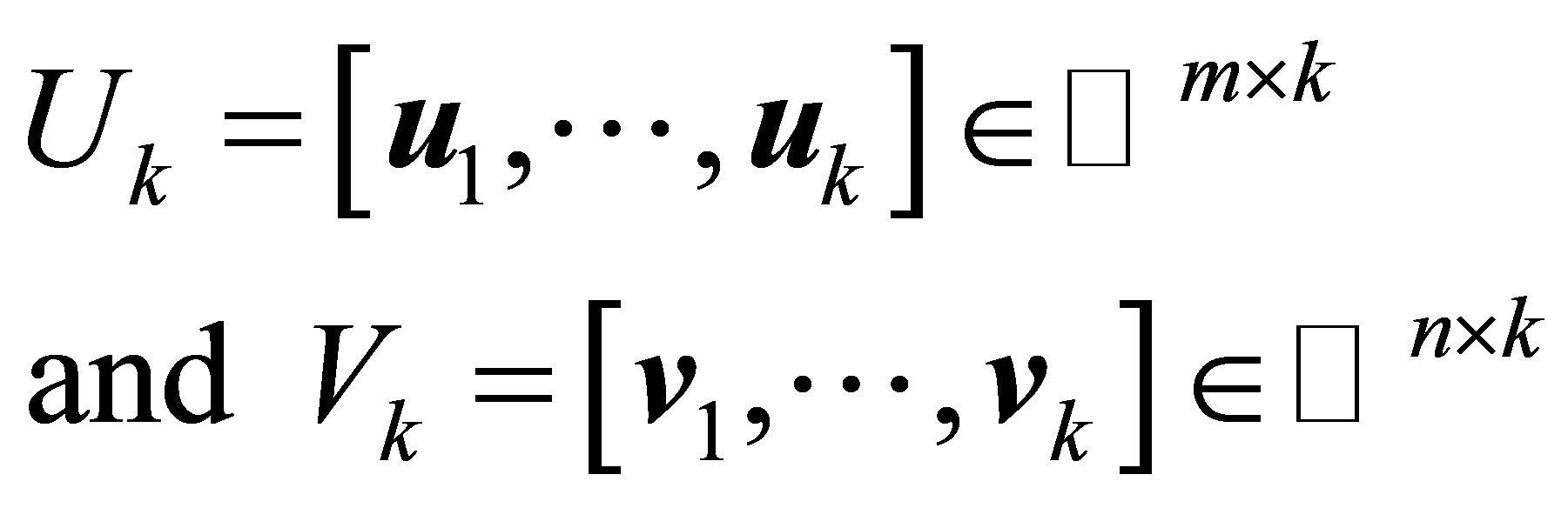

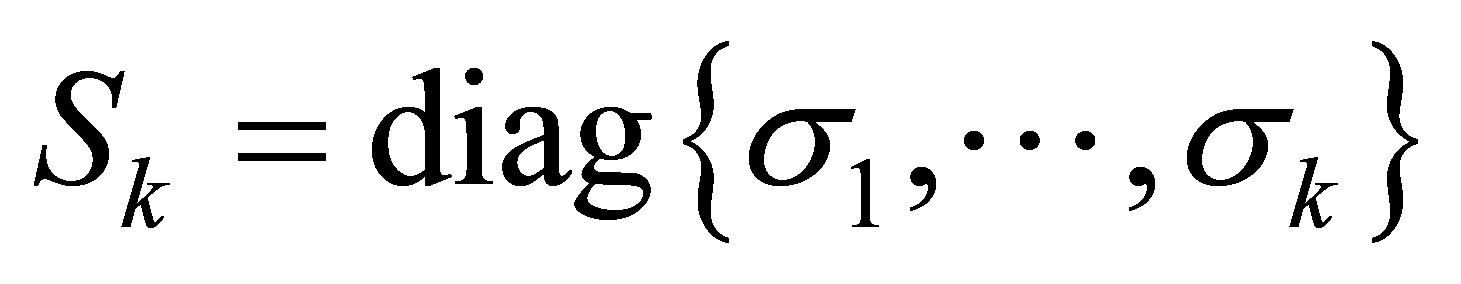

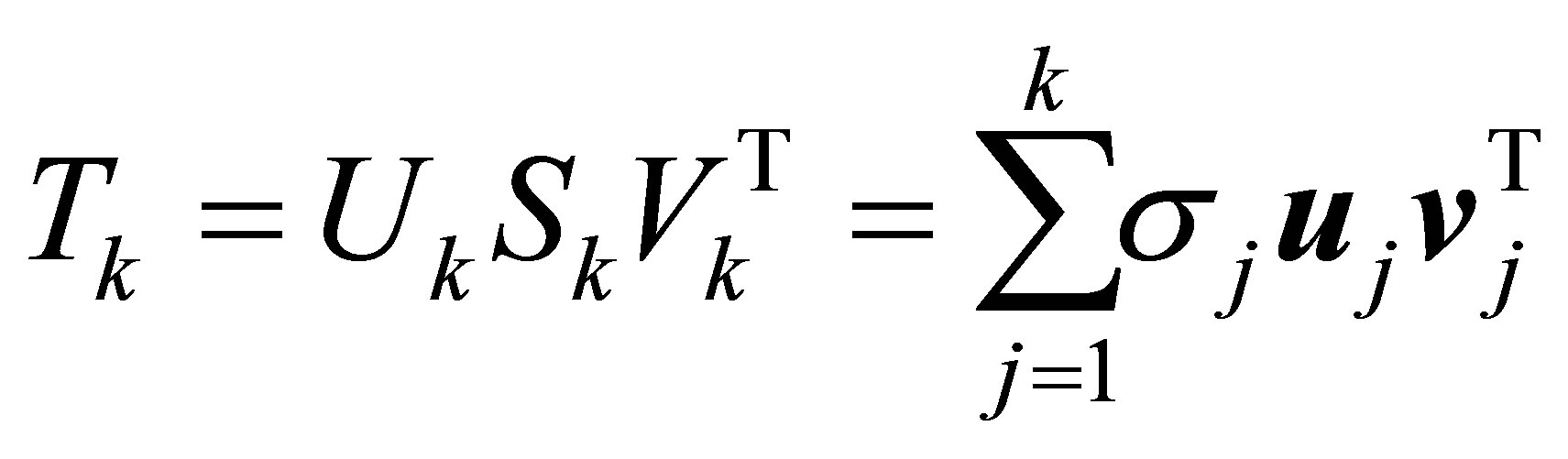

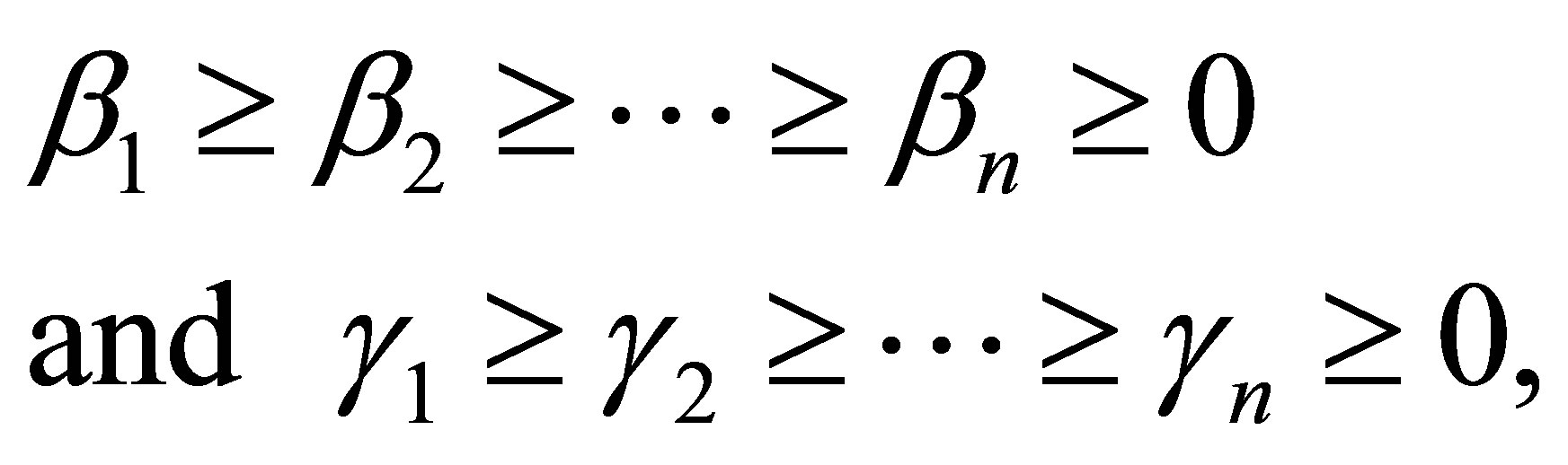

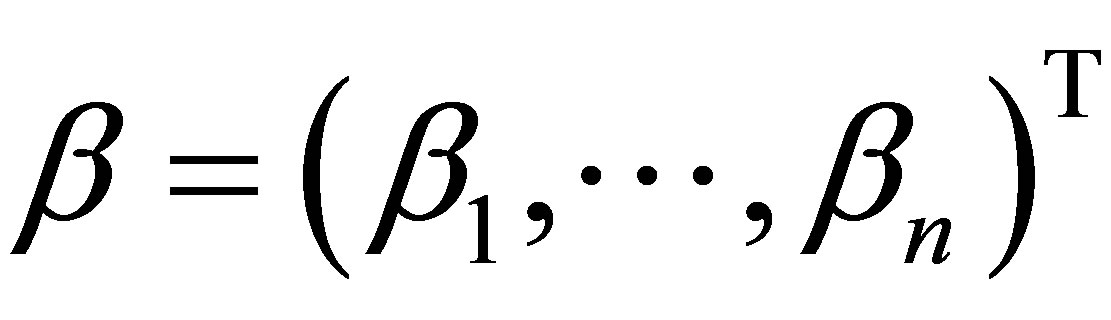

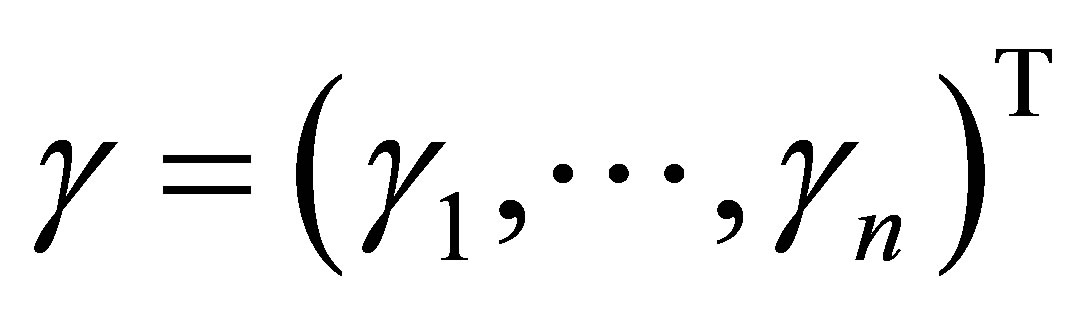

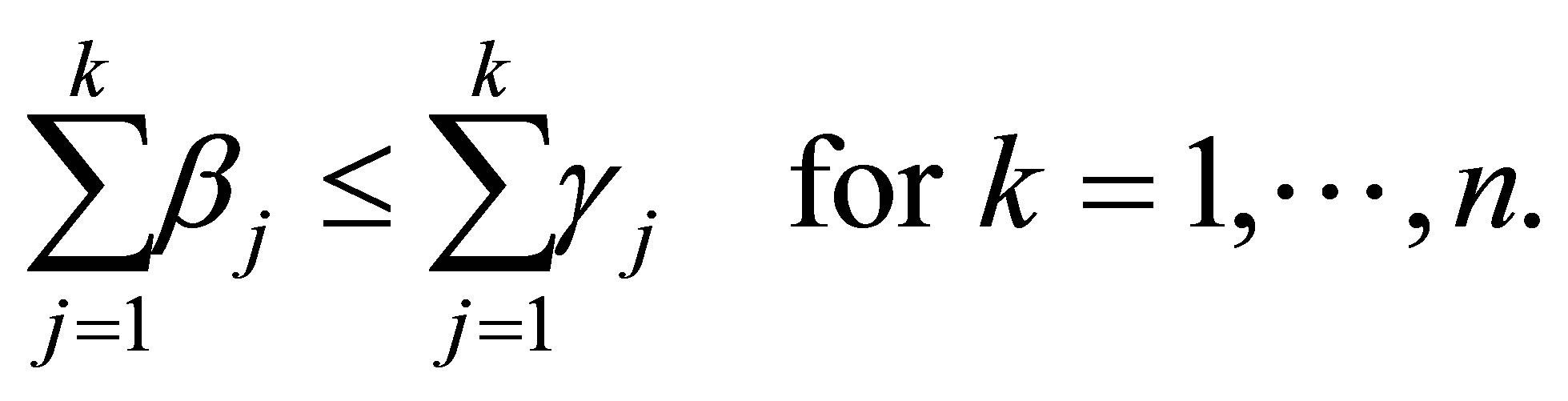

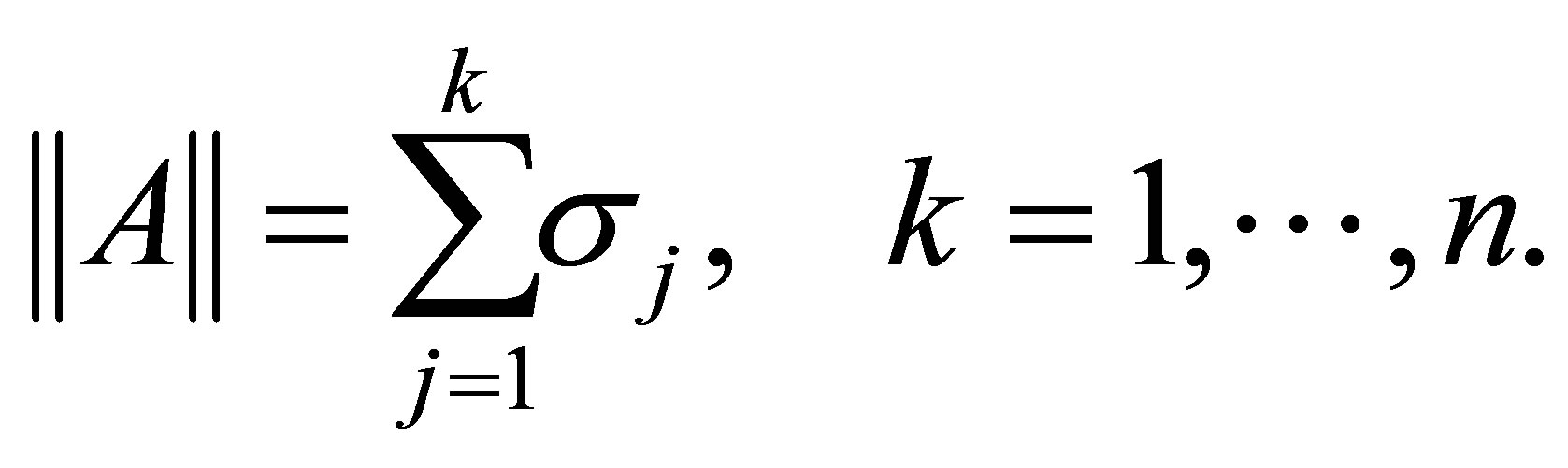

ما دیده ایم که اصول Extremum Ky Fan ردپای ماتریس های متقارن Rayleigh Quotient را به حداکثر می رساند و به حداقل می رساند. در این بخش نتایج آنالوگ از نظر ماتریس مستطیل آورده ایم. برای این منظور ردیابی یک ![]() ماتریس مستطیلی را به صورت زیر تعریف می کنیم

ماتریس مستطیلی را به صورت زیر تعریف می کنیم

(10.1)

(10.1)

که در آن  . با این تعریف موجود مشکلات جدید برای حل وجود دارد

. با این تعریف موجود مشکلات جدید برای حل وجود دارد

(10.2)

(10.2)

و

(10.3)

(10.3)

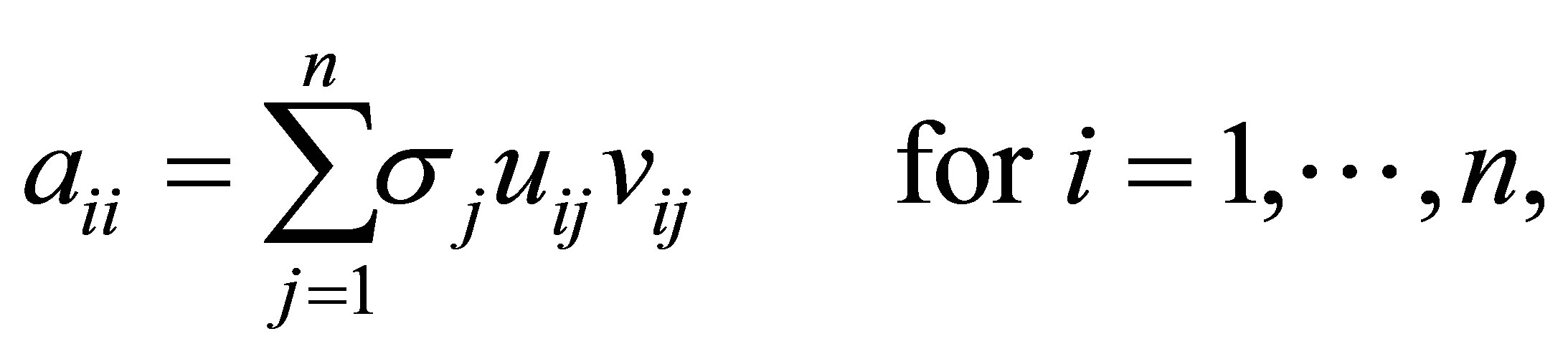

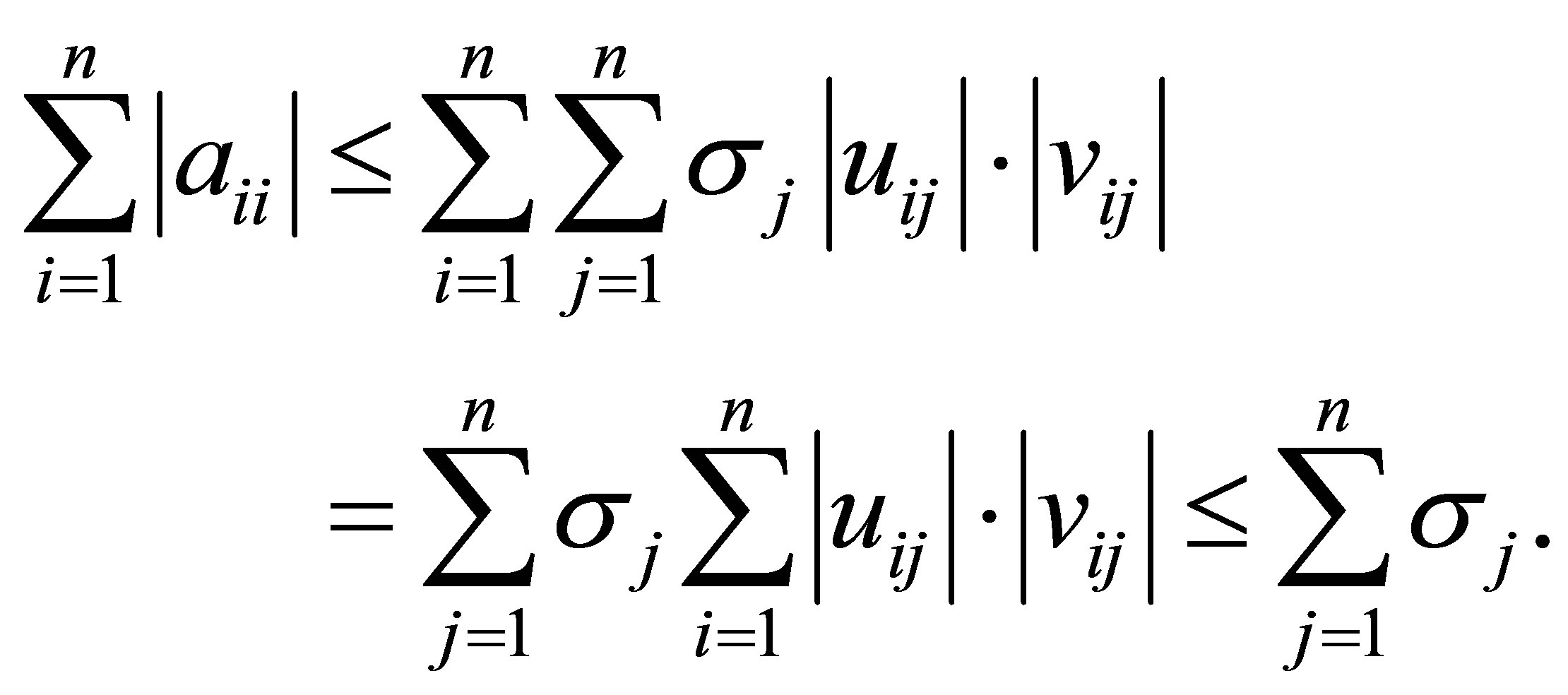

با استفاده از (2.10) می بینیم که

و

(10.4)

(10.4)

از طرف دیگر ، ماتریس ها ![]() و

و ![]() حل کننده ها (8.1) را برآورده می کنند

حل کننده ها (8.1) را برآورده می کنند

(10.5)

(10.5)

و

(10.6)

(10.6)

که منجر به نتیجه گیری زیر می شود.

نتیجه گیری 35 ماتریس ![]() و

و ![]() حل (10.2)

حل (10.2)

دادن مقدار بهینه از ![]() . به این معنا که،

. به این معنا که،

(10.7)

(10.7)

نتیجه 36 ماتریس ها ![]() و

و ![]() (یا

(یا ![]() و

و

![]() ) حل (10.3) با دادن مقدار بهینه از

) حل (10.3) با دادن مقدار بهینه از  .

.

به این معنا که

(10.8)

(10.8)

سرانجام توجه داریم که وقتی  ماتریس

ماتریس  به یک ماتریس مربع تبدیل می شود و نتیجه گیری 35 به نتیجه شناخته شده زیر کاهش می یابد.

به یک ماتریس مربع تبدیل می شود و نتیجه گیری 35 به نتیجه شناخته شده زیر کاهش می یابد.

(10.9)

(10.9)

به عنوان مثال ، [17 ، ص. 195] ، [22 ، ص. 515 ~] ، [ 24 ].

11. محصولات مقادیر ویژه در برابر محصولات با ارزشهای واحد

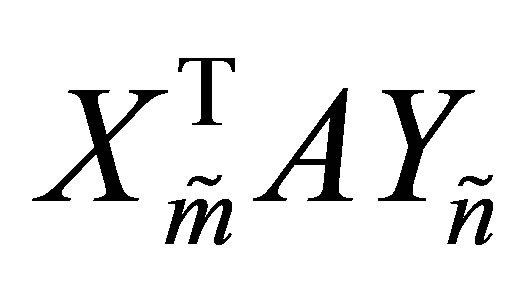

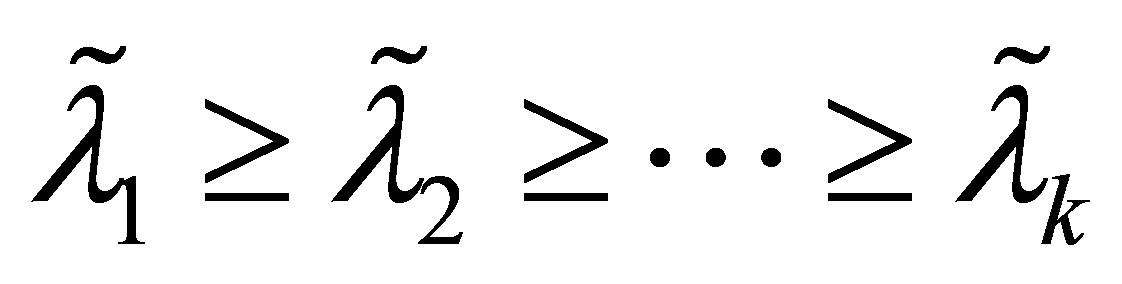

کی فن از اصول افراطی خود استفاده کرده است (نتیجه 22) برای بدست آوردن نتایج آنالوگ در تعیین ماتریس های نیمه نهایی مثبت Rayleigh Quotient (به زیر مراجعه کنید). در این بخش از اصل جدید (قضیه 32) برای گسترش این نتایج به ماتریس های متعامد ضریب استفاده شده است. علاقه به این مشکلات از ویژگی های زیر ماتریس های متقارن ناشی می شود. بگذارید G یک ![]() ماتریس نیمه نهایی مثبت و متقارن با مقادیر ویژه باشد

ماتریس نیمه نهایی مثبت و متقارن با مقادیر ویژه باشد

اجازه دهید  یک

یک ![]() ماتریس دلخواه با ستونهای متعادل باشد ، و اجازه دهید

ماتریس دلخواه با ستونهای متعادل باشد ، و اجازه دهید

مقادیر ویژه ![]() ماتریس را نشان می دهد

ماتریس را نشان می دهد  . سپس ، به وضوح ،

. سپس ، به وضوح ،

(11.1)

(11.1)

در حالی که نتیجه گیری 21 حاکی از نابرابری ها است

(11.2)

(11.2)

اجازه دهید که ماتریس ![]() و

و ![]() به عنوان نتیجه در 22. تعریف سپس مقادیر ویژه ماتریس

به عنوان نتیجه در 22. تعریف سپس مقادیر ویژه ماتریس ![]() و

و  هستند

هستند

به ترتیب. از این رو (11.2) می بینیم که

(11.3)

(11.3)

و

(11.4)

(11.4)

که در آن ارزش های مطلوب برای ماتریس به دست آمده ![]() و

و ![]() ، به ترتیب. تقویت بیشتر (11.4) با استفاده از قضیه تعیین کننده هادامارد بدست می آید ، که می گوید تعیین کننده یک ماتریس نیمه نهایی مثبت متقارن

، به ترتیب. تقویت بیشتر (11.4) با استفاده از قضیه تعیین کننده هادامارد بدست می آید ، که می گوید تعیین کننده یک ماتریس نیمه نهایی مثبت متقارن  ، کوچکتر از محصول ورودی های مورب آن است. به این معنا که،

، کوچکتر از محصول ورودی های مورب آن است. به این معنا که،

(11.5)

(11.5)

جایی که ![]() ستون j را نشان می دهد

ستون j را نشان می دهد ![]() . ترکیب (11.5) با (11.1) و (11.2) نابرابری می دهد

. ترکیب (11.5) با (11.1) و (11.2) نابرابری می دهد

(11.6)

(11.6)

برای هر ماتریس  . همچنین ، همانطور که دیدیم ، برابری چه زمانی (11.6) برقرار است

. همچنین ، همانطور که دیدیم ، برابری چه زمانی (11.6) برقرار است  . این ما را به مشاهده زیر از Ky Fan می رساند [ 12 ].

. این ما را به مشاهده زیر از Ky Fan می رساند [ 12 ].

قضیه 37 (Ky Fan)

(11.7)

(11.7)

و مقدار بهینه برای آن بدست می آید ![]() .

. ![]()

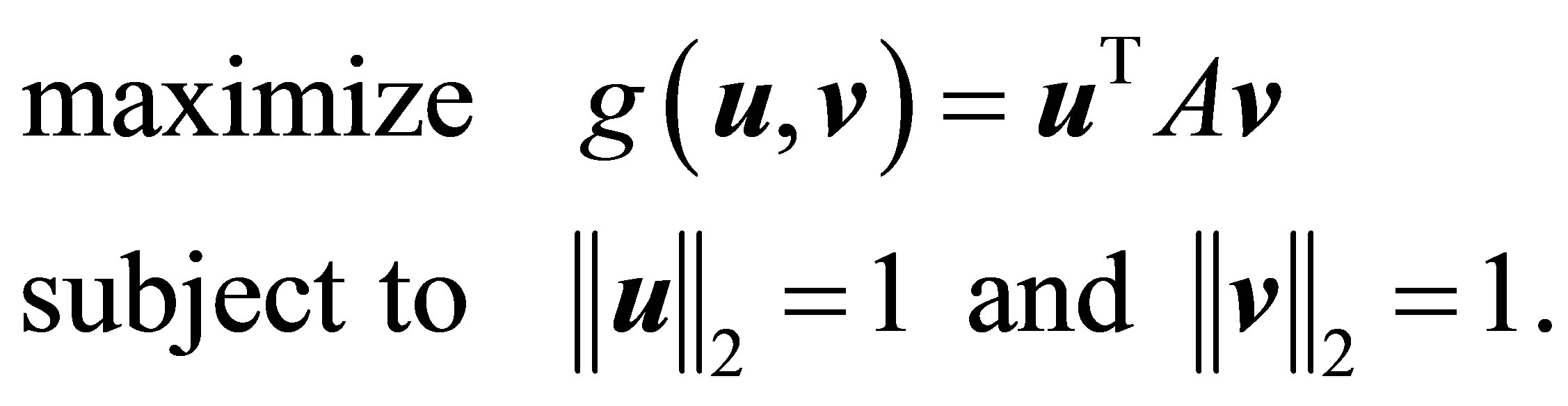

بیایید اکنون برگردیم تا ماتریس های ضریب مستطیلی مستطیلی را در نظر بگیریم. با استفاده از نمادهای بخش 8 ، مشکلاتی که می خواهیم حل کنیم

(11.8)

(11.8)

و

(11.9)

(11.9)

(مقایسه با (8.1) و (8.2) بود.) اجازه دهید ماتریس ![]() و

و ![]() به عنوان در قضیه 26. تعریف با استفاده از (2.1) یکی توانید بررسی کنید که

به عنوان در قضیه 26. تعریف با استفاده از (2.1) یکی توانید بررسی کنید که  ، است که ارزش حداکثر پاسخ ممکن، و (8.7). این ما را به نتیجه گیری زیر می رساند.

، است که ارزش حداکثر پاسخ ممکن، و (8.7). این ما را به نتیجه گیری زیر می رساند.

قضیه 38

(11.10)

(11.10)

و مقدار بهینه برای ![]() و بدست می آید

و بدست می آید ![]() .

. ![]()

نتیجه گیری 39 اگر  آنگاه باشد

آنگاه باشد

(11.11)

(11.11)

در کجا ![]() و

و ![]() در (2.7) تعریف شده است.

در (2.7) تعریف شده است. ![]()

راه حل (11.9) با پیروی از نکات و اثبات قضیه 29 پیدا می شود.

قضیه 40 ماتریس ها ![]() و

و ![]() حل (11.9). تعداد مقادیر منفرد مثبت ماتریس

حل (11.9). تعداد مقادیر منفرد مثبت ماتریس  است

است  . اگر

. اگر ![]() پس

پس

(11.12)

(11.12)

در غیر این صورت ![]() ،

،

(11.13)

(11.13)

![]()

به یاد بیاورید که ![]() . از این رو برابری

. از این رو برابری ![]() فقط در مواقعی امکان پذیر است که r = n باشد. اگر

فقط در مواقعی امکان پذیر است که r = n باشد. اگر ![]() در این صورت برابرها

در این صورت برابرها ![]() و r = n دلالت دارند

و r = n دلالت دارند  و

و  . در غیر این صورت ، وقتی

. در غیر این صورت ، وقتی  ، برابری

، برابری ![]() حاکی از آن است که

حاکی از آن است که  یا

یا ![]() .

.

نتیجه گیری 41 اگر ![]() آنگاه

آنگاه

(11.14)

(11.14)

12. سخنان جمع بندی

طبق یک گفته قدیمی ، کل اوقات می تواند خیلی بیشتر از مجموع قطعات آن باشد. رویه ریلی-ریتز ، قضیه اكارت-یانگ و اصل حداكثر Ky Fan نتایج اساسی هستند كه چندین كاربرد دارند. مشاهده اینکه این موضوعات با هم ارتباط نزدیک دارند جدید و تعجب آور است. این مسائل را در پرتو جدید روشن می کند.

اصل حداکثر توسعه یافته ابزاری قدرتمند است که پیامدهای مهمی دارد. به طور خاص می بینیم که هم حداکثر مشکل اكارت-یانگ و هم حداكثر مسئله Ky Fan موارد خاصی از این مشاهده هستند. قضیه حداقل حداکثر ، مسئله حداکثر گسترده را با مسئله حداقل هنجار میرسکی متصل می کند.

Achiya Dax این بررسی نگاهی دوم به نتایج Ky Fan می دهد که مقادیر ویژه ماتریس های متقارن Rayleigh Quitient را در نظر می گیرند. این نتایج را به نسخه های "مستطیل شکل" که مقادیر منفرد ماتریس های ضرایب متعامد را در نظر می گیرند ، گسترش می دهد. اثبات ها سودمندی قضیه سلطه Ky Fan را نشان می دهد. با استفاده از این قضیه قضیه میرسکی به راحتی از قضیه ویل استخراج می شود. به همین ترتیب ، به ایجاد اصل افراط و تفریط گسترده کمک می کند.

منبع

https://file.scirp.org/Html/2-5300515_41122.htm

9. حداقل و حداکثر برابری

برابری ضرایب متعامد (6.1) مسئله حداقل Eckart-Young را با یک مسئله حداکثر معادل متصل می کند. اعتبار این برابری به خصوصیات خاص هنجار ماتریس Frobenius بستگی دارد. س raisedالی که در این بخش مطرح شده این است که آیا امکان گسترش این برابری به سایر هنجارهای ماتریس یکنواخت ثابت نیز وجود دارد؟ به عبارت دیگر ، مسئله حداقل هنجار میرسکی (22/4) مربوط به مسئله حداکثر هنجار (18/8) است. قضیه های بعدی در هنگام استفاده از Shatten -norm ![]() (2.16) در شکل قدرت خود ، به این س answerال پاسخ می دهند ،

(2.16) در شکل قدرت خود ، به این س answerال پاسخ می دهند ،

(9.1)

(9.1)

قضیه 33 (حداقل-حداکثر برابری) فرض کنید که  . در این حالت تابع توان (9.1) برابری را برآورده می کند

. در این حالت تابع توان (9.1) برابری را برآورده می کند

(9.2)

(9.2)

اثبات مقدار بهینه اصطلاح به حداقل رسیده توسط قضیه 9 (قضیه میرسکی) آورده شده است ، و این مقدار برابر است  . مقدار بهینه مسئله دیگر با حداکثر اصل (8.13) تعیین می شود و این مقدار برابر است

. مقدار بهینه مسئله دیگر با حداکثر اصل (8.13) تعیین می شود و این مقدار برابر است ![]() .

. ![]()

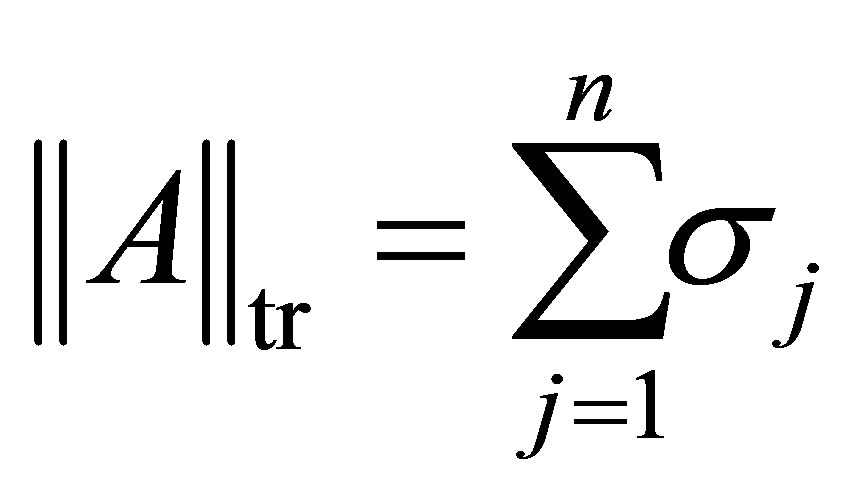

اگر ![]() تابع توان (9.1) با هنجار ردیابی (18/2) مطابقت داشته باشد. در این حالت (9.2) نتیجه زیبا زیر را به همراه دارد.

تابع توان (9.1) با هنجار ردیابی (18/2) مطابقت داشته باشد. در این حالت (9.2) نتیجه زیبا زیر را به همراه دارد.

(9.3)

(9.3)

ما دیده ایم که مسئله به حداقل رساندن میرسکی (22/4) و حداکثر مسئله (18/8) دارای یک ویژگی مشترک هستند: مقادیر بهینه هر دو مسئله برای ماتریس های SVD بدست می آیند ، ![]() و

و ![]() . این مشاهده ما را قادر می سازد تا حداقل حداکثر برابری را به سایر هنجارهای یکنواخت ثابت تغییر دهیم. به عنوان مثال هنجار طیفی را در نظر بگیرید (19/2). در این حالت (9.3) با جایگزین می شود

. این مشاهده ما را قادر می سازد تا حداقل حداکثر برابری را به سایر هنجارهای یکنواخت ثابت تغییر دهیم. به عنوان مثال هنجار طیفی را در نظر بگیرید (19/2). در این حالت (9.3) با جایگزین می شود

(9.4)

(9.4)

بعداً به یاد بیاورید که ستون های jth ماتریس های SVD یک جفت بردار منفرد تشکیل می دهند که مربوط به یکدیگر است ![]() . در واقع ، این خاصیت است که برابری در (9.2) را تضمین می کند. این راه را برای نوع دیگری از برابری فاکتورهای متعامد هموار می کند.

. در واقع ، این خاصیت است که برابری در (9.2) را تضمین می کند. این راه را برای نوع دیگری از برابری فاکتورهای متعامد هموار می کند.

قضیه 34 اجازه دهید ماتریس  و

و  از جفت بردار منحصر به فرد از تشکیل

از جفت بردار منحصر به فرد از تشکیل ![]() . به این معنا که

. به این معنا که  ، و برای

، و برای  ، ستون j ام از این ماتریس را برآورده سازد:

، ستون j ام از این ماتریس را برآورده سازد:

، و ضریب مستطیل

، و ضریب مستطیل  یک مقدار منفرد از است

یک مقدار منفرد از است ![]() . در این حالت تابع توان (9.1) برابری را برآورده می کند

. در این حالت تابع توان (9.1) برابری را برآورده می کند

![]() (9.5)

(9.5)

اثبات این اصطلاح  شامل

شامل ![]() قدرتهایی با ارزشهای منفرد است ، در حالی که اصطلاح دیگر شامل سایر

قدرتهایی با ارزشهای منفرد است ، در حالی که اصطلاح دیگر شامل سایر ![]() قدرتها است.

قدرتها است. ![]()

منبع

https://file.scirp.org/Html/2-5300515_41122.htm

8. به حداکثر رساندن (به حداقل رساندن) هنجارهای ماتریس فاکتورهای متعامد

بیایید برگردیم تا ماتریس های ضریب متعامد فرم را در نظر بگیریم (5.1). تعریف کردن

و اجازه دهید

مقادیر منفرد ماتریس ضرایب متعامد را نشان می دهد  . ما باید با بررسی مشکلات شروع کنیم

. ما باید با بررسی مشکلات شروع کنیم

(8.1)

(8.1)

و

(8.2)

(8.2)

![]() عدد مثبت مشخص کجاست ،

عدد مثبت مشخص کجاست ،  . با این حال نتایج آینده ما را قادر می سازد تا خانواده بزرگتری از توابع هدف را مدیریت کنیم. شاید جالب ترین مشکلات این نوع در هنگام

. با این حال نتایج آینده ما را قادر می سازد تا خانواده بزرگتری از توابع هدف را مدیریت کنیم. شاید جالب ترین مشکلات این نوع در هنگام ![]() و

و ![]() . در این موارد عملکرد هدف به کاهش می یابد

. در این موارد عملکرد هدف به کاهش می یابد

(8.3)

(8.3)

و

(8.4)

(8.4)

به ترتیب. به طور خاص ، زمان ![]() و

و  مسئله (8.1) با مسئله اكارت-یانگ (12/6) همزمان است. حل (8.1) و (8.2) براساس پسوندهای "مستطیلی" قضیه های 20 و 21 است. قضیه اول به دلیل تامپسون است [ 37 ]. ما برای اثبات روشن بودن رابطه نزدیک آن با قضیه کاوسی اینترلاس ، اثبات آن را بیان می کنیم.

مسئله (8.1) با مسئله اكارت-یانگ (12/6) همزمان است. حل (8.1) و (8.2) براساس پسوندهای "مستطیلی" قضیه های 20 و 21 است. قضیه اول به دلیل تامپسون است [ 37 ]. ما برای اثبات روشن بودن رابطه نزدیک آن با قضیه کاوسی اینترلاس ، اثبات آن را بیان می کنیم.

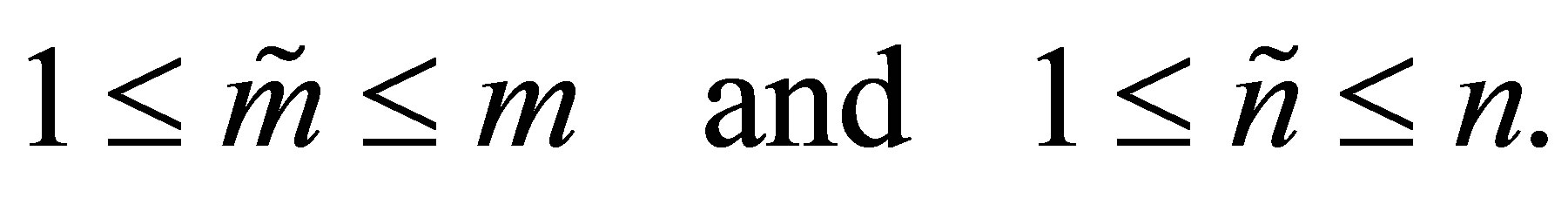

قضیه 23 (قضیه بینابینی کوشی مستطیلی) اجازه دهید با حذف سطرها و ستون های ![]() ماتریس

ماتریس ![]() بدست آید . یعنی ، و . تعریف کردن

بدست آید . یعنی ، و . تعریف کردن![]()

![]()

![]()

![]()

و اجازه دهید

مقادیر واحد را نشان می دهد ![]() . سپس

. سپس

![]() (8.5)

(8.5)

بعلاوه ، تعداد مقادیر مثبت منفرد ![]() از پایین به زیر محدود می شود

از پایین به زیر محدود می شود

که در آن  . در نتیجه

. در نتیجه ![]() ، و اگر

، و اگر ![]() اولین

اولین ![]() مقادیر مفرد

مقادیر مفرد ![]() مرزهای پایین را برآورده می کند

مرزهای پایین را برآورده می کند

![]() (8.6)

(8.6)

اثبات اثبات این است ![]() که

که  تعداد کلی ردیف ها و ستون های حذف شده از طریق القای روشن است. زیرا

تعداد کلی ردیف ها و ستون های حذف شده از طریق القای روشن است. زیرا ![]() دو مورد وجود دارد که باید در نظر گرفته شود. ابتدا فرض کنید که

دو مورد وجود دارد که باید در نظر گرفته شود. ابتدا فرض کنید که ![]() با حذف یک ردیف به دست می آید

با حذف یک ردیف به دست می آید ![]() . سپس با استفاده از قضیه 20 با

. سپس با استفاده از قضیه 20 با  و

و  به نتایج مورد نظر می دهد. احتمال دوم این است که

به نتایج مورد نظر می دهد. احتمال دوم این است که ![]() با حذف یک ستون از بدست می آید

با حذف یک ستون از بدست می آید ![]() . در این حالت از قضیه 20 با

. در این حالت از قضیه 20 با  و استفاده می شود

و استفاده می شود  . استدلالهای مشابه ما را قادر می سازد تا مرحله استقرا را به پایان برسانیم.

. استدلالهای مشابه ما را قادر می سازد تا مرحله استقرا را به پایان برسانیم. ![]()

مشاهده کنید که مرزها (8.5) و (8.6) "سخت" هستند به این معنا که این مرزها می توانند به عنوان برابری برآورده شوند. به عنوان مثال ، یک ماتریس مورب را در نظر بگیرید.

نتیجه گیری 24 (قضیه تفکیک مستطیلی Poincaré)![]() ماتریس را در نظر بگیرید

ماتریس را در نظر بگیرید  ، کجا

، کجا  و کجا

و کجا  . اجازه دهید

. اجازه دهید

مقادیر منفرد ![]() ، کجا را نشان می دهد

، کجا را نشان می دهد  . سپس

. سپس

![]() (8.7)

(8.7)

بعلاوه ، مشخص کنید  که r = رتبه (A)

که r = رتبه (A)  ، و

، و  . سپس

. سپس ![]() و اگر

و اگر ![]() اولین

اولین ![]() مقادیر منفرد

مقادیر منفرد ![]() مرزهای پایین را برآورده می کند

مرزهای پایین را برآورده می کند

![]() (8.8)

(8.8)

اثبات اجازه دهید ماتریس  با تکمیل ستونها بدست آید

با تکمیل ستونها بدست آید ![]() تا مبنایی متعادل باشد

تا مبنایی متعادل باشد ![]() . اجازه دهید ماتریس

. اجازه دهید ماتریس  با تکمیل ستونها بدست آید

با تکمیل ستونها بدست آید ![]() تا مبنایی متعادل باشد

تا مبنایی متعادل باشد ![]() . سپس

. سپس ![]() ماتریس

ماتریس  همان مقادیر واحد را دارد

همان مقادیر واحد را دارد ![]() ، و

، و ![]() از

از  حذف آخرین

حذف آخرین ![]() سطرها و

سطرها و ![]() ستون های آخر بدست می آید .

ستون های آخر بدست می آید .

نتیجه گیری 25 با استفاده از نمادهای قبلی ، ![]()

![]() (8.9)

(8.9)

و

(8.10)

(8.10)

بعلاوه ، اگر ![]() آن وقت باشد

آن وقت باشد

![]() (8.11)

(8.11)

و

(8.12)

(8.12)

نابرابری های مشابه وقتی که تابع توان  با هر تابع با ارزش واقعی دیگری که در فاصله زمانی افزایش می یابد جایگزین می شود

با هر تابع با ارزش واقعی دیگری که در فاصله زمانی افزایش می یابد جایگزین می شود  .

.

قضیه 26 (یک اصل حداکثر مستطیلی) اجازه دهید ![]() ماتریس

ماتریس  از اولین

از اولین ![]() ستونها ساخته شود

ستونها ساخته شود ![]() ، و اجازه دهید

، و اجازه دهید ![]() ماتریس

ماتریس  از

از ![]() ستونهای اول ساخته شود

ستونهای اول ساخته شود ![]() . (آن را به یاد بیاورید

. (آن را به یاد بیاورید ![]() و

و ![]() SVD را تشکیل دهید

SVD را تشکیل دهید![]() ، به (2.1) - (2.8) مراجعه کنید.) سپس این جفت ماتریس با ارائه مقدار بهینه

، به (2.1) - (2.8) مراجعه کنید.) سپس این جفت ماتریس با ارائه مقدار بهینه

![]() . به این معنا که،

. به این معنا که،

(8.13)

(8.13)

با این حال ، ماتریس های راه حل لزوماً منحصر به فرد نیستند.

اثبات اثبات نتیجه مستقیم (8.10) و این واقعیت است که  یک

یک ![]() ماتریس مورب است که ورودی های مورب آن است

ماتریس مورب است که ورودی های مورب آن است  .

. ![]()

نتیجه گیری 27 (حداکثر اصل Ky Fan مستطیلی) حالت خاص را در نظر بگیرید که چه زمانی ![]() . در این مورد

. در این مورد

(8.14)

(8.14)

و مقدار بهینه برای ماتریسها بدست می آید ![]() و

و ![]() .

.

نتیجه گیری 28 مورد خاص را در نظر بگیرید وقتی که ![]() . در این مورد

. در این مورد

(8.15)

(8.15)

و مقدار بهینه برای ماتریسها بدست می آید ![]() و

و ![]() . بعلاوه ، اگر

. بعلاوه ، اگر  پس از آن (8.15) به (12/6) کاهش یابد. این یک روش جایگزین برای اثبات قضیه اكارت-یانگ است.

پس از آن (8.15) به (12/6) کاهش یابد. این یک روش جایگزین برای اثبات قضیه اكارت-یانگ است.

قضیه 29 (یک اصل حداقل مستطیلی) اجازه دهید با حذف ستون های اول ![]() ماتریس

ماتریس  بدست آید . اجازه دهید با حذف ماتریس حاصل شود

بدست آید . اجازه دهید با حذف ماتریس حاصل شود![]()

![]()

![]()

![]()

![]()

![]()

![]() ستون به روش زیر: اگر

ستون به روش زیر: اگر  پس از آن

پس از آن ![]() از اول تشکیل

از اول تشکیل ![]() ستون از

ستون از ![]() . در غیر این صورت، هنگامی که

. در غیر این صورت، هنگامی که  ، اولین

، اولین ![]() ستون از

ستون از ![]() اولین هستند

اولین هستند ![]() ستون از

ستون از ![]() ، و ستون بقیه

، و ستون بقیه ![]() آخرین می

آخرین می  ستون از

ستون از![]() . سپس ماتریس

. سپس ماتریس ![]() و

و ![]() حل مشکل حداقل (8.2). مقدار بهینه (8.2) به عدد صحیح بستگی دارد

حل مشکل حداقل (8.2). مقدار بهینه (8.2) به عدد صحیح بستگی دارد  . اگر

. اگر ![]() مقدار بهینه برابر با صفر باشد. در غیر این صورت ، چه زمانی

مقدار بهینه برابر با صفر باشد. در غیر این صورت ، چه زمانی

![]() ، مقدار بهینه برابر است

، مقدار بهینه برابر است  .

.

اثبات اجازه دهید با حذف اولین ستون های ![]() ماتریس

ماتریس ![]() از

از ![]() ماتریس هویت بدست آید . سپس، به وضوح، . به طور مشابه، تعریف می شود ماتریس به طوری که . به این معنا که،

ماتریس هویت بدست آید . سپس، به وضوح، . به طور مشابه، تعریف می شود ماتریس به طوری که . به این معنا که، ![]()

![]()

![]()

![]()

![]()

![]()

![]() با حذف ستونهای مربوطه از ماتریس هویت بدست می آید . با در دست داشتن این نشانه ها (2.1) دلالت بر برابری ها دارد

با حذف ستونهای مربوطه از ماتریس هویت بدست می آید . با در دست داشتن این نشانه ها (2.1) دلالت بر برابری ها دارد

بنابراین ماتریس  از

از ![]() طریق حذف

طریق حذف ![]() سطرها و

سطرها و ![]() ستون های مربوطه بدست می آید .

ستون های مربوطه بدست می آید .

مشاهده کنید که ورودی های غیر صفر باقیمانده  مقادیر منفرد این ماتریس هستند. همچنین توجه داشته باشید که قانون حذف سطرها و ستون ها از

مقادیر منفرد این ماتریس هستند. همچنین توجه داشته باشید که قانون حذف سطرها و ستون ها از ![]() هدف این است که اندازه ورودی های غیر صفر باقیمانده را تا حد ممکن کوچک کند: محصول

هدف این است که اندازه ورودی های غیر صفر باقیمانده را تا حد ممکن کوچک کند: محصول ![]() اولین

اولین ![]() ردیف های

ردیف های ![]() بزرگترین

بزرگترین ![]() مقادیر منفرد را حذف می کند. سپس محصول

مقادیر منفرد را حذف می کند. سپس محصول

![]() بزرگترین مقادیر بعدی بعدی را نابود می کند . ورودی های غیر صفر باقی مانده از

بزرگترین مقادیر بعدی بعدی را نابود می کند . ورودی های غیر صفر باقی مانده از ![]() این رو کمترین ورودی هایی هستند که می توانیم بدست آوریم.

این رو کمترین ورودی هایی هستند که می توانیم بدست آوریم.  به طور واضح ، تعداد مقادیر مثبت منفرد در ، است

به طور واضح ، تعداد مقادیر مثبت منفرد در ، است  . بهینه بودن راه حل ما از (8.8) و (12.12) ناشی می شود.

. بهینه بودن راه حل ما از (8.8) و (12.12) ناشی می شود. ![]()

یکی دیگر از جفت ماتریس است که حل (8.2) است با معکوس کردن ترتیب که در آن ما سطر و ستون از حذف به دست آورد ![]() شروع با حذف اولین:

شروع با حذف اولین: ![]() ستون از

ستون از ![]() ، که شامل

، که شامل ![]() بزرگترین مقادیر منفرد. سپس

بزرگترین مقادیر منفرد. سپس ![]() ردیف های بزرگترین مقادیر

ردیف های بزرگترین مقادیر ![]() بعدی را حذف کنید

بعدی را حذف کنید ![]() .

.

نتیجه گیری 30 (حداقل اصل مستطیلی Ky Fan) مورد خاص را در نظر بگیرید که چه زمانی ![]() و

و ![]() . در این مورد

. در این مورد

(8.16)

(8.16)

و مقدار بهینه برای ماتریسها بدست می آید ![]() و

و ![]() .

.

نتیجه گیری 31 مورد خاص را در نظر بگیرید وقتی ![]() و

و ![]() . در این مورد

. در این مورد

(8.17)

(8.17)

و مقدار بهینه برای ماتریسها بدست می آید ![]() و

و ![]() .

.

قضیه بعدی نتایج ما را به هنجارهای خودسرانه تغییرناپذیر گسترش می دهد.

قضیه 32 اجازه دهید ![]() یک هنجار منحصر به فرد ثابت باشد

یک هنجار منحصر به فرد ثابت باشد ![]() . سپس ماتریس ها

. سپس ماتریس ها ![]() و

و ![]() ، که (8.1) را حل می کنند ، مسئله را نیز حل می کنند

، که (8.1) را حل می کنند ، مسئله را نیز حل می کنند

(8.18)

(8.18)

به همین ترتیب ماتریس ها ![]() و

و ![]() (8.2) را حل می کنند ، همچنین مسئله را حل می کنند

(8.2) را حل می کنند ، همچنین مسئله را حل می کنند

(8.19)

(8.19)

اثبات از (8.7) می بینیم که مقادیر منفرد توسط مقادیر اصلی بزرگ می  شوند

شوند  . این نشان می دهد که

. این نشان می دهد که

![]() (8.20)

(8.20)

که ادعای اول را ثابت می کند. به طور مشابه ، (8.8) به این معنی است که مقادیر منفرد توسط مقادیر مربوط  به بزرگ می شوند

به بزرگ می شوند  . این نشان می دهد که

. این نشان می دهد که

![]() (8.21)

(8.21)

که ادعای دوم را اثبات می کند. ![]()

منبع

https://file.scirp.org/Html/2-5300515_41122.htm

7. برابری مقدارهای متقارن و اصول افراطی Ky Fan

اجازه دهید  یک

یک ![]() ماتریس متقارن واقعی با تجزیه طیفی باشد

ماتریس متقارن واقعی با تجزیه طیفی باشد

![]() (7.1)

(7.1)

که در آن  است مورب

است مورب ![]() matrixand

matrixand  متعامد

متعامد ![]() ماتریس،

ماتریس،

. فرض بر این است که مقادیر ویژه

. فرض بر این است که مقادیر ویژه ![]() برای برآورده سازی مرتب شده اند

برای برآورده سازی مرتب شده اند

![]() (7.2)

(7.2)

اجازه دهید  یک

یک ![]() ماتریس داده شده با ستونهای متعادل و اجازه دهید

ماتریس داده شده با ستونهای متعادل و اجازه دهید

![]() ماتریس مورب را نشان می دهد که مورب را تشکیل می دهد

ماتریس مورب را نشان می دهد که مورب را تشکیل می دهد  . به یاد بیاورید

. به یاد بیاورید

در تحولات مشابهت (متعامد) ثابت نیست. از این رو با پیروی از اثبات (6.1) نتایج زیر را بدست می آوریم.

قضیه 19 (برابری مقدارهای متقارن) با استفاده از نمادهای فوق ،

(7.3)

(7.3)

و

(7.4)

(7.4)

جایی که

![]()

توجه داشته باشید که قضیه 19 وقتی ![]() با هر

با هر ![]() ماتریس واقعی جایگزین شود ، معتبر باقی می ماند . نقش تقارن در مسائلی که سعی در به حداکثر رساندن یا به حداقل رساندن دارند برجسته می شود

ماتریس واقعی جایگزین شود ، معتبر باقی می ماند . نقش تقارن در مسائلی که سعی در به حداکثر رساندن یا به حداقل رساندن دارند برجسته می شود  ، همانطور که توسط کی فن در نظر گرفته شده است [ 10 ]. در یادداشت های ما ، مشکلات Ky Fan دارای شکلی است

، همانطور که توسط کی فن در نظر گرفته شده است [ 10 ]. در یادداشت های ما ، مشکلات Ky Fan دارای شکلی است

(7.5

(7.5

و

(7.6)

(7.6)

راه حل این مشکلات در ویژگی های معروف زیر ماتریس های متقارن نهفته است ، به عنوان مثال ، [16،30،40].

قضیه 20 (قضیه بین کوشی) اجازه دهید با حذف سطرها و ستونهای مربوطه ![]() ماتریس

ماتریس ![]() بدست آید . اجازه دهید

بدست آید . اجازه دهید![]()

![]()

مقادیر ویژه از ![]() . سپس

. سپس

(7.7)

(7.7)

به طور خاص  ،

،

![]() (7.8)

(7.8)

![]()

نتیجه گیری 21 (قضیه جدایی Poincaré) اجازه دهید  یک

یک ![]() ماتریس داده شده با ستونهای

ماتریس داده شده با ستونهای  متعامد طبیعی داشته باشد و یک

متعامد طبیعی داشته باشد و یک ![]() ماتریس متعامد باشد ، که

ماتریس متعامد باشد ، که ![]() ستونهای اول ستونهای آن است

ستونهای اول ستونهای آن است ![]() . سپس با حذف آخرین مورد

. سپس با حذف آخرین مورد  بدست می آید

بدست می آید

ردیف ها و

ردیف ها و ![]() ستون های آخر . بنابراین ، از آنجا که

ستون های آخر . بنابراین ، از آنجا که  دارای مقادیر ویژه همان مقادیر

دارای مقادیر ویژه همان مقادیر ![]() ویژه

ویژه ![]() رضایت (7.7) و (7.8) است.

رضایت (7.7) و (7.8) است.

نتیجه 22 (اصول Extremum Ky Fan) تجزیه طیفی (7.1) - (7.2) را در نظر بگیرید و اجازه دهید ماتریس  از اولین ستون های k ساخته شود

از اولین ستون های k ساخته شود ![]() . سپس

. سپس ![]() (7.5) را حل می کند ، مقدار بهینه را می دهد

(7.5) را حل می کند ، مقدار بهینه را می دهد ![]() . به این معنا که،

. به این معنا که،

(7.9)

(7.9)

حداقل مسئله ردیابی (7.6) توسط ماتریس حل می شود

که از آخرین ![]() ستونهای تشکیل شده است

ستونهای تشکیل شده است ![]() . بنابراین ، مقدار بهینه (7.6) است

. بنابراین ، مقدار بهینه (7.6) است  . به این معنا که،

. به این معنا که،

(7.10)

(7.10)

![]()

برابری ضرایب متقارن (7.3) به این معنی است که مشکلات Ky Fan ، (7.5) و (7.6) ، معادل مشکلات است

(7.11)

(7.11)

و

(7.12)

(7.12)

به ترتیب. به شباهت چشمگیر مشکلات Eckart-Young (6.8) و (6.12) و Ky Fan (7.11) و (7.5) توجه کنید.

با در نظر گرفتن موردی که G نیمه نهایی مثبت است ، بینش بیشتری به دست می آید. در این حالت تجزیه طیفی (7.1) - (7.2) با SVD همزمان می شود ![]() و

و ![]() ماتریس

ماتریس  نیز نیمه نهایی مثبت است. اجازه دهید

نیز نیمه نهایی مثبت است. اجازه دهید

![]() (7.13)

(7.13)

مقادیر ویژه (مقادیر منفرد) این ماتریس را نشان می دهد. سپس در اینجا روابط درهم آمیخته (7.7) دلالت بر روابط عمده سازی بین مقادیر واحد  و مقادیر واحد ماتریس ها دارد

و مقادیر واحد ماتریس ها دارد ![]()

و  . در نتیجه ، برای هر هنجار واحدی که ثابت باشد

. در نتیجه ، برای هر هنجار واحدی که ثابت باشد ![]() ، ماتریس

، ماتریس ![]() مسئله را حل می کند

مسئله را حل می کند

(7.14)

(7.14)

در حالی ![]() که مشکل را حل می کند

که مشکل را حل می کند

(7.15)

(7.15)

در بخش بعدی ما از ماتریس های ضامن متعامد متقارن به ماتریس های مستطیلی می رویم. در این حالت ارزشهای منفرد نقش مقادیر ویژه را دارند. با این حال ، همانطور که خواهیم دید ، تشبیه بین دو مورد همیشه ساده نیست.

منبع

https://file.scirp.org/Html/2-5300515_41122.htm

6. برابری امتیازات متعامد و قضیه اكارت-یانگ

در این بخش ما برابری فاکتورهای متعامد را استخراج کرده و در مورد رابطه آن با قضیه اكارت-یانگ بحث می كنیم.

قضیه 14 (برابری مقدارهای متعامد) اجازه دهید  و

و  یک جفت ماتریس مشخص با ستونهای متعادل داشته باشید. سپس

یک جفت ماتریس مشخص با ستونهای متعادل داشته باشید. سپس

![]() (6.1)

(6.1)

اثبات به دنبال اثبات قضیه 11 می بینیم که

![]() (6.2)

(6.2)

جایی که

بنابراین ، از آنجا  که زیرماتریک اصلی است

که زیرماتریک اصلی است  ،

،

نتیجه گیری 15 اجازه دهید  هر

هر ![]() ماتریسی باشد که ورودی های آن مطابق با قانون زیر باشد: یا

ماتریسی باشد که ورودی های آن مطابق با قانون زیر باشد: یا  یا

یا

![]() . به عبارت دیگر ،

. به عبارت دیگر ، ![]() از

از  صفر قرار دادن برخی از ورودی ها بدست می آید . سپس

صفر قرار دادن برخی از ورودی ها بدست می آید . سپس

![]() (6.3)

(6.3)

نتیجه 16 (متعامد خارج قسمت برابری در فرم مورب) اجازه دهید  و

و  یک جفت داده از ماتریس با ستون orthonormal. سپس ماتریس مورب (5.10) برآورده می شود

یک جفت داده از ماتریس با ستون orthonormal. سپس ماتریس مورب (5.10) برآورده می شود

![]() (6.4)

(6.4)

در نمادهای برداری آخرین برابری شکل می گیرد

(6.5)

(6.5)

![]()

بیایید اکنون برگردیم تا مشکل Eckart-Young را بررسی کنیم (4.20). یکی از روشهای بیان ![]() ماتریس ، که رتبه آن حداکثر است

ماتریس ، که رتبه آن حداکثر است ![]() ، می باشد

، می باشد

![]() (6.6)

(6.6)

که در آن  ،

،  و

و  . متناوبا ما می توانیم

. متناوبا ما می توانیم ![]() در فرم بنویسیم

در فرم بنویسیم

(6.7)

(6.7)

ماتریس  مورب واقعی کجاست

مورب واقعی کجاست ![]() (شکل اول از تجزیه کامل متعامد حاصل می شود

(شکل اول از تجزیه کامل متعامد حاصل می شود ![]() ، در حالی که فرم دوم از SVD حاصل می شود.) جایگزینی (6/6) در عملکرد هدف (20/4) منجر به عملکرد می شود

، در حالی که فرم دوم از SVD حاصل می شود.) جایگزینی (6/6) در عملکرد هدف (20/4) منجر به عملکرد می شود  . از این رو ، توسط قضیه 11 ، از دست دادن عمومیت در جایگزینی

. از این رو ، توسط قضیه 11 ، از دست دادن عمومیت در جایگزینی ![]() با وجود ندارد

با وجود ندارد  . به همین ترتیب D را می توان با جایگزین کرد

. به همین ترتیب D را می توان با جایگزین کرد![]() ، راه حل (5.11). این مشاهدات منجر به نتیجه گیری زیر می شود.

، راه حل (5.11). این مشاهدات منجر به نتیجه گیری زیر می شود.

قضیه 17 (فرمولهای معادل مسئله EckartYoung) در نوشتن مسئله Eckart-Young (4.20) در فرمها هیچ افت کلی وجود ندارد.

(6.8)

(6.8)

یا

(6.9)

(6.9)

علاوه بر این ، هر دو مشکل توسط ماتریس SVD ![]() و حل می شوند

و حل می شوند ![]() . (برای تعریف این ماتریس ها به (2.1) - (2.7) مراجعه کنید.)

. (برای تعریف این ماتریس ها به (2.1) - (2.7) مراجعه کنید.) ![]()

عملکردهای عینی آخرین مشکلات ، جناح چپ برابری فاکتورهای متعامد را تشکیل می دهد

![]() (6.10)

(6.10)

و

![]() (6.11)

(6.11)

این روابط حداقل مشکلات هنجار (8/6) - (9/6) را به حداکثر معادلات نرمال تبدیل می کند.

قضیه 18 (حداکثر فرمول بندی نرمال مسئله اكارت-یانگ) مسائل اكارت-یانگ (6.8) و (6.9) معادل مسایل است

(6.12)

(6.12)

و

(6.13)

(6.13)

به ترتیب. ماتریس SVD ![]() و

و ![]() حل هر دو مشکل.

حل هر دو مشکل. ![]()

بگذارید  ، مقادیر منفرد ماتریس ضرایب متعامد را نشان دهیم

، مقادیر منفرد ماتریس ضرایب متعامد را نشان دهیم  . سپس ، به وضوح ،

. سپس ، به وضوح ،

![]() (6.14)

(6.14)

و مسئله اكارت-یانگ (6.12) را می توان دوباره نوشت

(6.15)

(6.15)

در بخشهای بعدی ، مشکلات گسترده این نوع را در نظر می گیریم. کلید حل مشکلات گسترده در خصوصیات ماتریس های ضریب متعامد متقارن نهفته است.

منبع

https://file.scirp.org/Html/2-5300515_41122.htm

5. حداقل ویژگیهای مربعات ماتریس های ضریب متعامد

خصوصیات بهینه سازی ماتریس های متقارن Rayleigh Quentient اساس روش مشهور RayleighRitz را تشکیل می دهند ، به عنوان مثال ، [30،34]. در این بخش خصوصیات مربوط به ماتریس های ضریب متعامد را بدست می آوریم. همانطور که خواهیم دید ، ماتریس های متعامد متعامد ماتریس های متقارن ریلی را به همان روشی که ضرایب مستطیل ضرایب ریلی را گسترش می دهند ، گسترش می دهند.

قضیه 11 بگذارید

و

و

یک جفت ماتریس مشخص با ستونهای متعادل باشد ، و اجازه دهید

![]() (5.1)

(5.1)

ماتریس ضریب متعامد مربوطه را نشان می دهد. سپس ![]() سه مشکل زیر را حل می کند.

سه مشکل زیر را حل می کند.

(5.2)

(5.2)

(5.3)

(5.3)

و

(5.4)

(5.4)

اثبات تکمیل ستون ها ![]() به عنوان یک قاعده طبیعی از

به عنوان یک قاعده طبیعی از ![]() یک

یک ![]() ماتریس متعامد

ماتریس متعامد ![]() ، که اولین

، که اولین ![]() ستون های آن ستون ها است ، می دهد

ستون های آن ستون ها است ، می دهد ![]() . به طور مشابه یک

. به طور مشابه یک ![]() ماتریس متعامد وجود دارد

ماتریس متعامد وجود دارد ![]() که اولین آن است

که اولین آن است ![]() ستون ها ستون های

ستون ها ستون های ![]() . بنابراین ، از آنجا که هنجار Frobenius بطور واحدی ثابت نیست ،

. بنابراین ، از آنجا که هنجار Frobenius بطور واحدی ثابت نیست ،

(5.5)

(5.5)

جایی که

(5.6)

(5.6)

اعتبار آخرین برابری با ذکر این نکته که ![]() ماتریس

ماتریس  از اولین

از اولین ![]() ستون های

ستون های ![]() ماتریس هویت تشکیل شده است ، به راحتی تأیید می شود ، در حالی که

ماتریس هویت تشکیل شده است ، به راحتی تأیید می شود ، در حالی که ![]() ماتریس

ماتریس ![]() از اولین

از اولین ![]() ردیف های

ردیف های ![]() ماتریس هویت. همچنین توجه داشته باشید که زیر متغیر اصلی مربوط به

ماتریس هویت. همچنین توجه داشته باشید که زیر متغیر اصلی مربوط به  است

است  . از این رو انتخاب به

. از این رو انتخاب به  حداقل می رسد

حداقل می رسد ![]() .

.

دو مسئله دیگر با استفاده از برابری با استدلال های مشابه حل می شوند

![]() (5.7)

(5.7)

و

![]() (5.8)

(5.8)

جایی که

(5.9)

(5.9)

![]()

تذکر بازرسی بیشتر از روابط (5.7) - (5.9) نشان می دهد که ![]() مشکلات (5.3) و (5.4) را حل می کند حتی اگر هنجار Frobenius با هر یک از هنجارهای ماتریس منحصر به فرد دیگری جایگزین شود. با این حال آخرین ادعا برای مسئله معتبر نیست (5.2) ، زیرا "مشت زدن" یک ماتریس ممکن است هنجار آن را افزایش دهد. برای دیدن این نکته ماتریس ها را در نظر بگیرید

مشکلات (5.3) و (5.4) را حل می کند حتی اگر هنجار Frobenius با هر یک از هنجارهای ماتریس منحصر به فرد دیگری جایگزین شود. با این حال آخرین ادعا برای مسئله معتبر نیست (5.2) ، زیرا "مشت زدن" یک ماتریس ممکن است هنجار آن را افزایش دهد. برای دیدن این نکته ماتریس ها را در نظر بگیرید

و

و  هنجارهای ردیابی آنها به ترتیب 2 و

هنجارهای ردیابی آنها به ترتیب 2 و ![]() است. یعنی مشت زدن

است. یعنی مشت زدن ![]() هنجار کمیاب آن را افزایش می دهد. با این وجود ، مشت زدن به یک ماتریس همیشه هنجار Frobenius را کاهش می دهد. از این رو اثبات قضیه 11 به نتایج قدرتمند زیر منجر می شود.

هنجار کمیاب آن را افزایش می دهد. با این وجود ، مشت زدن به یک ماتریس همیشه هنجار Frobenius را کاهش می دهد. از این رو اثبات قضیه 11 به نتایج قدرتمند زیر منجر می شود.

نتیجه گیری 12 اجازه دهید ![]() مجموعه تمام

مجموعه تمام ![]() ماتریس های واقعی که الگوی صفر خاصی دارند را نشان دهیم. (به عنوان مثال ، مجموعه تمام ماتریس های سه ضلعی) اجازه دهید ماتریس

ماتریس های واقعی که الگوی صفر خاصی دارند را نشان دهیم. (به عنوان مثال ، مجموعه تمام ماتریس های سه ضلعی) اجازه دهید ماتریس  از

از  طریق تنظیم صفر در مکان های مربوطه بدست آید . سپس قضیه 11 وقتی معتبر باقی می ماند

طریق تنظیم صفر در مکان های مربوطه بدست آید . سپس قضیه 11 وقتی معتبر باقی می ماند ![]() و با

و با  آنها جایگزین می شود

آنها جایگزین می شود ![]() و

و ![]() به ترتیب

به ترتیب ![]()

نتیجه 13 فرض کنید  و اجازه دهید

و اجازه دهید

مجموعه تمام ![]() ماتریس های مورب واقعی را نشان می دهد . اجازه دهید

ماتریس های مورب واقعی را نشان می دهد . اجازه دهید  و

و  یک جفت ماتریس مشخص با ستونهای متعادل باشد. سپس ماتریس

یک جفت ماتریس مشخص با ستونهای متعادل باشد. سپس ماتریس

![]() (5.10)

(5.10)

سه مشکل زیر را حل می کند.

(5.11)

(5.11)

(5.12)

(5.12)

و

(5.13)

(5.13)

![]()

همانند مورد اسکالر ، توابع باقیمانده ، ![]() و

و ![]() ما را قادر می سازد تا "فاصله" بین مقادیر منفرد

ما را قادر می سازد تا "فاصله" بین مقادیر منفرد ![]() و

و ![]() . برای لحظه ای فرض کنید

. برای لحظه ای فرض کنید  و بگذارید

و بگذارید  مقادیر واحد را نشان دهد

مقادیر واحد را نشان دهد ![]() . آنگاه یک جایگشت وجود دارد

. آنگاه یک جایگشت وجود دارد ![]() از

از  جمله که

جمله که

(5.14)

(5.14)

رجوع شود به [2،21]. روابط (5.7) - (5.9) نشان می دهد که حداقل مقادیر برابر ![]() و

و ![]() برابر هنجار Frobenius بلوک های خارج مورب متناظر در ماتریس

برابر هنجار Frobenius بلوک های خارج مورب متناظر در ماتریس  . مشاهدات بعدی مربوط به حداقل مقدار

. مشاهدات بعدی مربوط به حداقل مقدار ![]() .

.

منبع

https://file.scirp.org/Html/2-5300515_41122.htm

4- از مقادیر ویژه تا مقادیر واحد

ارتباط بین مقادیر منفرد ![]() و مقادیر ویژه ماتریس های A T A ، AA T و

و مقادیر ویژه ماتریس های A T A ، AA T و کاملاً ساده است در واقع ، بسیاری از خصوصیات مقادیر منفرد از این اتصال به ارث می رسند. با این حال ، همانطور که بررسی ما نشان می دهد ، عمق روابط بسیار فراتر از این ارتباط اساسی است. قضیه مینیمکس Courant-Fischer و قضیه Weyl نتایج بسیار مفیدی را در مقادیر ویژه ماتریس های متقارن ارائه می دهند. برای جزئیات بحث در مورد این قضیه ها و پیامدهای آن به [1،30] مراجعه کنید. در زیر سازگاری این نتایج را هنگام حرکت از مقادیر ویژه به مقادیر واحد در نظر می گیریم. از قضیه های سازگار برای ارائه اثبات "سنتی" قضیه اكارت-یانگ استفاده می شود.

کاملاً ساده است در واقع ، بسیاری از خصوصیات مقادیر منفرد از این اتصال به ارث می رسند. با این حال ، همانطور که بررسی ما نشان می دهد ، عمق روابط بسیار فراتر از این ارتباط اساسی است. قضیه مینیمکس Courant-Fischer و قضیه Weyl نتایج بسیار مفیدی را در مقادیر ویژه ماتریس های متقارن ارائه می دهند. برای جزئیات بحث در مورد این قضیه ها و پیامدهای آن به [1،30] مراجعه کنید. در زیر سازگاری این نتایج را هنگام حرکت از مقادیر ویژه به مقادیر واحد در نظر می گیریم. از قضیه های سازگار برای ارائه اثبات "سنتی" قضیه اكارت-یانگ استفاده می شود.

مانند قبل ![]() یک

یک ![]() ماتریس واقعی را نشان می دهد که SVD آن با (2.1) - (2.7) داده شده است. جفت اول قضیه ها خصوصیات مفید "minimax" از مقادیر واحد را ارائه می دهد. در این قضایا

ماتریس واقعی را نشان می دهد که SVD آن با (2.1) - (2.7) داده شده است. جفت اول قضیه ها خصوصیات مفید "minimax" از مقادیر واحد را ارائه می دهد. در این قضایا ![]() نشانگر یک فضای خرده دلخواه از

نشانگر یک فضای خرده دلخواه از ![]() بعد است

بعد است ![]() . به طور مشابه ،

. به طور مشابه ، ![]() یک فضای خرده دلخواه از

یک فضای خرده دلخواه از ![]() بعد نشان می دهد

بعد نشان می دهد ![]() .

.

قضیه 1 (قضیه Minimax سمت راست Courant-Fischer) ارزش انحصاری jth از ![]() رضایت مندی ها

رضایت مندی ها

![]() (4.1)

(4.1)

و

(4.2)

(4.2)

جایی که عدد صحیح ![]() با برابری تعریف می شود

با برابری تعریف می شود

![]() (4.3)

(4.3)

(حداکثر در (4.1) از همه است ![]() زیرفضاهای بعدی

زیرفضاهای بعدی ![]() از

از ![]() . حداقل در (4.2) از همه است

. حداقل در (4.2) از همه است ![]() زیرفضاهای بعدی

زیرفضاهای بعدی ![]() از

از ![]() .) علاوه بر این، حداکثر در (4.1) برای به دست آمده

.) علاوه بر این، حداکثر در (4.1) برای به دست آمده  ، در حالی که حداقل در (4.2) برای به دست آمده

، در حالی که حداقل در (4.2) برای به دست آمده

.

.

با این حال راه حل های هر دو مشکل لزوماً منحصر به فرد نیستند. ![]()

قضیه 2 (قضیه Minimax Legend Courant-Fischer) ارزش انفرادی ![]() رضایت

رضایت

![]() (4.4)

(4.4)

و

![]() (4.5)

(4.5)

جایی که عدد صحیح ![]() با برابری تعریف می شود

با برابری تعریف می شود

![]() (4.6)

(4.6)

علاوه بر این ، حداکثر در (4.4) برای بدست آمده است

در حالی که حداقل در (4.5) برای بدست آمده است

در حالی که حداقل در (4.5) برای بدست آمده است

.

. ![]()

توجه داشته باشید که قضیه 2 در اصل قضیه 1 برای است ![]() . اثبات قضیه 1 بر اساس ایده زیر است. شرط (4.3) تضمین می کند وجود یک بردار واحد،

. اثبات قضیه 1 بر اساس ایده زیر است. شرط (4.3) تضمین می کند وجود یک بردار واحد، ![]() که هر دو متعلق به

که هر دو متعلق به ![]() و

و ![]() . بدین ترتیب

. بدین ترتیب

و

بنابراین اثبات با تأیید برابری هنگام استفاده از زیر فضاهای مشخص شده به نتیجه می رسد.

بگذارید ![]() یک

یک ![]() ماتریس واقعی دیگر را نشان دهیم و بگذارید

ماتریس واقعی دیگر را نشان دهیم و بگذارید

![]() (4.7)

(4.7)

ماتریس اختلاف مربوطه را نشان می دهد. مقادیر منفرد ![]() و

و ![]() به عنوان نشان داده می شوند

به عنوان نشان داده می شوند

![]() (4.8)

(4.8)

به ترتیب. نتیجه های بعدی قضیه 1 به این سوال پاسخ می دهد که چگونه رتبه ![]() بر مقادیر واحد تأثیر می گذارد

بر مقادیر واحد تأثیر می گذارد ![]() .

.

لما 3 فرض کنید که  . در این مورد

. در این مورد

![]() (4.9)

(4.9)

اثبات نگاهی  . سپس

. سپس  و

و  . در نتیجه

. در نتیجه

جایی که آخرین نابرابری از (4.2) ناشی می شود. ![]()

قضیه 4 (ویل) بگذارید ![]() و

و ![]() مانند (4.7) - (4.8) باشد. سپس

مانند (4.7) - (4.8) باشد. سپس

![]() (4.10)

(4.10)

تحت این کنوانسیون که  وقتی

وقتی ![]() .

.

اثبات بگذارید ![]() یک

یک ![]() SVD کوتاه شده از یک

SVD کوتاه شده از یک ![]() ، و

، و ![]() یک

یک ![]() SVD کوتاه شده یک درجه

SVD کوتاه شده یک درجه ![]() باشد. سپس بزرگترین مقدار مفرد از

باشد. سپس بزرگترین مقدار مفرد از  است

است ![]() ، در حالی که بزرگترین مقدار مفرد از

، در حالی که بزرگترین مقدار مفرد از  است

است ![]() . به این معنا که،

. به این معنا که،

![]() (4.11)

(4.11)

و

![]() (4.12)

(4.12)

اجازه دهید ![]() ماتریس

ماتریس ![]() با برابری تعریف شود

با برابری تعریف شود

سپس  ، و

، و

از این رو (4.11) و (4.12) می بینیم که

جایی که آخرین نابرابری از Lemma 3 ناشی می شود. ![]()

نتیجه 5 (Majorization) دوباره فرض که  ، که به معنی

، که به معنی  برای

برای  . سپس با جایگزینی

. سپس با جایگزینی  (4.10) می توانید جایگزین کنید

(4.10) می توانید جایگزین کنید

![]() (4.13)

(4.13)

به عبارت دیگر ، اگر  در این صورت مقادیر

در این صورت مقادیر ![]() منفرد مقادیر منفرد را بزرگ می کند

منفرد مقادیر منفرد را بزرگ می کند  .

. ![]()

به یاد بیاورید که ![]() نشان دهنده یک

نشان دهنده یک ![]() SVD کوتاه شده از درجه است

SVD کوتاه شده از درجه است ![]() ، همانطور که در (2.8) تعریف شده است. به طور تقریبی ، آخرین نتیجه گیری می گوید که

، همانطور که در (2.8) تعریف شده است. به طور تقریبی ، آخرین نتیجه گیری می گوید که ![]() اغتشاش در مرتبه

اغتشاش در مرتبه ![]() ممکن است باعث شود که مقادیر واحد بیش از

ممکن است باعث شود که مقادیر واحد بیش از ![]() «سطح» سقوط نکند . نتیجه بعدی نشان می دهد که آنها قادر به "افزایش" بیش از

«سطح» سقوط نکند . نتیجه بعدی نشان می دهد که آنها قادر به "افزایش" بیش از ![]() سطح نیستند.

سطح نیستند.

نتیجه 6 مشاهده کنید که (4.7) می تواند دوباره نوشته شود  در حالی که

در حالی که ![]() دارای مقادیر منفرد یکسانی است

دارای مقادیر منفرد یکسانی است ![]() . از این رو نتیجه دیگری از قضیه 4 است

. از این رو نتیجه دیگری از قضیه 4 است

![]() (4.14)

(4.14)

علاوه بر این ، اگر  آن وقت باشد

آن وقت باشد

![]() (4.15)

(4.15)

![]()

نتایج بعدی مرزهای مفیدی را در مقادیر مفرد آشفته ایجاد می کنند.

نتیجه 7 (محدوده و درهم بافته) با استفاده از (4.10) و (4.14) با ![]() می دهد

می دهد

![]() (4.16)

(4.16)

و

![]() (4.17)

(4.17)

بعلاوه ، مورد خاص را در نظر بگیرید که ![]() ماتریس رتبه یک باشد. سپس با استفاده از (4.13) و (4.15) همراه با داده

ماتریس رتبه یک باشد. سپس با استفاده از (4.13) و (4.15) همراه با داده ![]() می شود

می شود

![]() (4.18)

(4.18)

که در آن  و

و  .

. ![]()

قضیه 8 (اكارت-یانگ) بگذارید ![]() و

و ![]() مانند (4.7) - (4.8) باشد و فرض كنید كه

مانند (4.7) - (4.8) باشد و فرض كنید كه  . سپس

. سپس

(4.19)

(4.19)

علاوه بر این ، اجازه دهید ![]() یک

یک ![]() SVD کوتاه شده از آن باشد

SVD کوتاه شده از آن باشد ![]() ، همانطور که در (2.8) تعریف شده است. سپس

، همانطور که در (2.8) تعریف شده است. سپس ![]() حداقل مسئله هنجار را حل می کند

حداقل مسئله هنجار را حل می کند

(4.20)

(4.20)

دادن مقدار بهینه از

اثبات با استفاده از (4.13) می بینیم که

![]()

آخرین قضیه می گوید که ![]() بهترین

بهترین ![]() تقریب

تقریب ![]() رتبه در مورد هنجار Frobenius است. مشاهده کنید که Lemma 3 ادعای مشابهی برای هنجار 2 را اثبات می کند. پسوند بعدی به دلیل میرسکی است [ 23 ].

رتبه در مورد هنجار Frobenius است. مشاهده کنید که Lemma 3 ادعای مشابهی برای هنجار 2 را اثبات می کند. پسوند بعدی به دلیل میرسکی است [ 23 ].

قضیه 9 (میرسکی) اجازه دهید ![]() یک هنجار منحصر به فرد ثابت را نشان دهد

یک هنجار منحصر به فرد ثابت را نشان دهد ![]() . سپس نابرابری

. سپس نابرابری

![]() (4.21)

(4.21)

نگه می دارد برای هر ماتریس  به طوری که

به طوری که  . به عبارت دیگر ،

. به عبارت دیگر ، ![]() مسئله حداقل هنجار را حل می کند

مسئله حداقل هنجار را حل می کند

(4.22)

(4.22)

اثبات از نتیجه 5 می بینیم که مقادیر منحصر به فرد بزرگ کردن مقادیر ![]() آن است

آن است  . از این رو (4.21) نتیجه مستقیم قضیه تسلط Ky Fan است.

. از این رو (4.21) نتیجه مستقیم قضیه تسلط Ky Fan است. ![]()

یکی دیگر از مشکلات مرتبط است

(4.23)

(4.23)

که ![]() نشانگر مجموعه تمام

نشانگر مجموعه تمام ![]() ماتریسهای واقعی درجه است

ماتریسهای واقعی درجه است ![]() . در زیر نشان خواهیم داد که ماتریس باقیمانده

. در زیر نشان خواهیم داد که ماتریس باقیمانده

(4.24)

(4.24)

این مشکل را حل می کند به عبارت دیگر ، ![]() کوچکترین آشفتگی است که

کوچکترین آشفتگی است که ![]() به یک

به یک ![]() ماتریس رتبه بندی تبدیل می شود .

ماتریس رتبه بندی تبدیل می شود .

قضیه 10 Let ![]() و C مانند (4.7) است و فرض کنید که

و C مانند (4.7) است و فرض کنید که

سپس

(4.25)

(4.25)

اثبات با استفاده از قضیه اكارت-یانگ به دست می آوریم

![]()

مشاهده کنید که ![]() حل این مسئله (4.23) هنگامی که این مسئله با هر هنجار غیرقابل تغییر دیگری تعریف می شود ، باقی می ماند. همچنین توجه داشته باشید که مشکلات Total Least Squares شکل خاصی از (23/4) را ایجاد می کند که در آن

حل این مسئله (4.23) هنگامی که این مسئله با هر هنجار غیرقابل تغییر دیگری تعریف می شود ، باقی می ماند. همچنین توجه داشته باشید که مشکلات Total Least Squares شکل خاصی از (23/4) را ایجاد می کند که در آن  . در این حالت ، ماتریس محلول ، به ماتریس

. در این حالت ، ماتریس محلول ، به ماتریس ![]() رتبه یک کاهش می یابد

رتبه یک کاهش می یابد  ، به عنوان مثال ، [14،15]. عواقب بیشتر قضیه اكارت-یانگ در بخش 6 ارائه شده است.

، به عنوان مثال ، [14،15]. عواقب بیشتر قضیه اكارت-یانگ در بخش 6 ارائه شده است.

منبع

https://file.scirp.org/Html/2-5300515_41122.htm

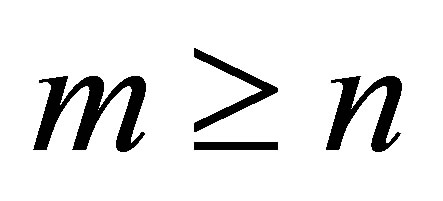

3. ضرایب مستطیل

اجازه دهید ![]() یک

یک ![]() ماتریس واقعی با

ماتریس واقعی با  ، و اجازه دهید

، و اجازه دهید

و

و  یک جفت بردار غیر صفر باشید. برای ساده کردن بحث های آینده ما را فرض هایی که

یک جفت بردار غیر صفر باشید. برای ساده کردن بحث های آینده ما را فرض هایی که  ، و

، و ![]() و

و ![]() بردار واحد می باشد. به این معنا که،

بردار واحد می باشد. به این معنا که،

با استفاده از این مفروضات ، مقدار مستطیل (1.6) به فرم دو خطی کاهش می یابد

![]() (3.1)

(3.1)

در این بخش ما مختصراً حداقل ویژگیهای اساسی حداقل را که مشخصه این نوع اشکال دو خطی است ، استخراج می کنیم. در ابتدا باید یادآوری کنیم که ![]() مسئله به حداقل رساندن یک پارامتر را حل می کند

مسئله به حداقل رساندن یک پارامتر را حل می کند

![]() (3.2)

(3.2)

این مشاهده نتیجه مستقیم برابری هاست

و

(3.3)

(3.3)

استدلال های مشابه نشان می دهد که  مشکلات حداقل مربعات را حل می کند

مشکلات حداقل مربعات را حل می کند

![]() (3.4)

(3.4)

و

![]() (3.5)

(3.5)

بعلاوه ، جایگزینی مقدار بهینه مقدار ![]() (3.3) ، برابری مقدار مستطیل را به دست می دهد

(3.3) ، برابری مقدار مستطیل را به دست می دهد

![]() (3.6)

(3.6)

که به معنی حل مسئله تقریب رتبه یک است

![]() (3.7)

(3.7)

معادل حل مسئله حداکثر است

(3.8)

(3.8)

با استفاده از SVD ![]() بردارهای واحد در آخرین مسئله می توان به صورت بیان شد

بردارهای واحد در آخرین مسئله می توان به صورت بیان شد

بنابراین ، از آن زمان

![]() (3.9)

(3.9)

عملکرد هدف (3.8) را برآورده می کند

جایی که آخرین نابرابری از نابرابری کوشی شوارتز ناشی می شود. علاوه بر این ، از آنجا که  ، این جفت بردار حل می شود (3.8) ، در حالی که

، این جفت بردار حل می شود (3.8) ، در حالی که ![]() رضایت بخش است

رضایت بخش است

(3.10)

(3.10)

آخرین نتیجه مشابه (1.4) است. با این حال ، در مقابل (1.5) ، در اینجا روابط متعامد بودن (3.9) بر این دلالت دارد

![]() (3.11)

(3.11)

خصوصیات حداقل حداکثر ضرایب مستطیل اسکالر از قضیه Courant-Fischer بدست آمده است ، به بخش بعدی مراجعه کنید.

توجیه دیگری که در پشت تعریف پیشنهادی ضریب مستطیل وجود دارد ، ناشی از مشاهده است که ضریب ریلی مربوط به ماتریس است

و بردار

و بردار  است

است  .

.

از این رو در این مورد حد (1.2) حاکی از وجود یک مقدار منحصر به فرد از ![]() ،

، ![]() که ارضا

که ارضا

(3.12)

(3.12)

آخرین محدوده را می توان با استفاده از قوانین بازیابی زیر ، که در [ 3 ] مشتق شده است ، اصلاح کرد . بگذارید  یک بردار واحد معین باشد که راضی کند

یک بردار واحد معین باشد که راضی کند  ، و اجازه دهید

، و اجازه دهید

و

به ترتیب برآورد مربوط به یک بردار مجرد چپ و یک مقدار واحد را ارائه دهید سپس

و (3.12) به کاهش می یابد

![]() (3.13)

(3.13)

به همین ترتیب اجازه دهید  یک بردار واحد معین باشد که راضی باشد

یک بردار واحد معین باشد که راضی باشد  ، و بگذارید

، و بگذارید

و

به ترتیب برآورد مربوط به یک بردار منفرد و یک مقدار واحد را نشان می دهد. پس اینجا

و (3.12) به کاهش می یابد

![]() (3.14)

(3.14)

این بخش را با ذکر تفاوت بین ضریب مستطیل (1.6) و مقدار ریلی تعمیم یافته (GRQ) پیشنهاد شده توسط Ostrowski به پایان خواهیم رساند [ 26 ]. اجازه دهید ![]() یک ماتریس مربع عمومی (غیر عادی) از نظم n باشد و اجازه دهید

یک ماتریس مربع عمومی (غیر عادی) از نظم n باشد و اجازه دهید ![]() و

و ![]() دو

دو ![]() بردار باشد که

بردار باشد که  در جایی که

در جایی که ![]() نشانگر انتقال جفت است ، راضی باشد

نشانگر انتقال جفت است ، راضی باشد ![]() . سپس GRQ ،

. سپس GRQ ،

![]() (3.15)

(3.15)

با هدف تقریب یک مقدار ویژه از ![]() "مشترک" برای

"مشترک" برای ![]() و

و ![]() . برای بحث های دقیق در مورد GRQ و خصوصیات آن به [25-27،29،40] مراجعه کنید.

. برای بحث های دقیق در مورد GRQ و خصوصیات آن به [25-27،29،40] مراجعه کنید.

منبع

https://file.scirp.org/Html/2-5300515_41122.htm

در این بخش ، ما نکات و حقایقی را که برای بحث در آینده لازم است ، معرفی می کنیم. مانند قبل ![]() یک

یک ![]() ماتریس واقعی را با نشان می دهد

ماتریس واقعی را با نشان می دهد  . اجازه دهید

. اجازه دهید

![]() (2.1)

(2.1)

یک SVD از ![]() ، که در آن

، که در آن  یک IS

یک IS ![]()

ماتریس متعامد ،  یک

یک ![]() ماتریس متعامد است ، و

ماتریس متعامد است ، و  یک

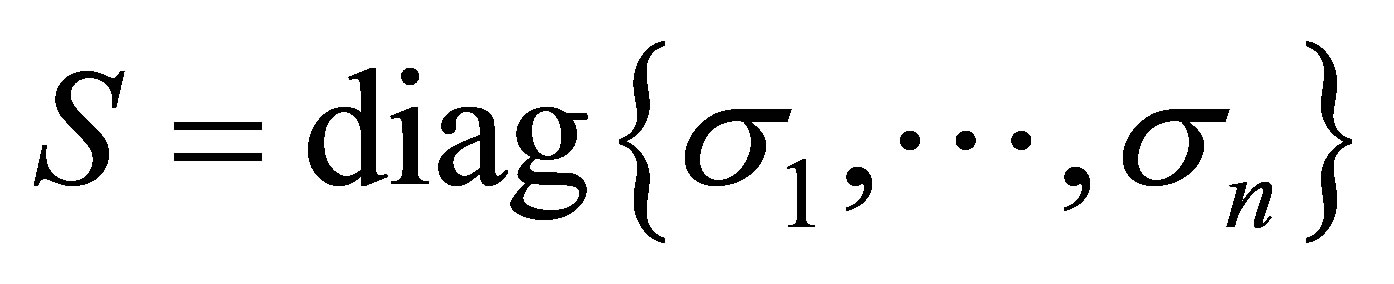

یک ![]() ماتریس مورب است. مقادیر منحصر به فرد

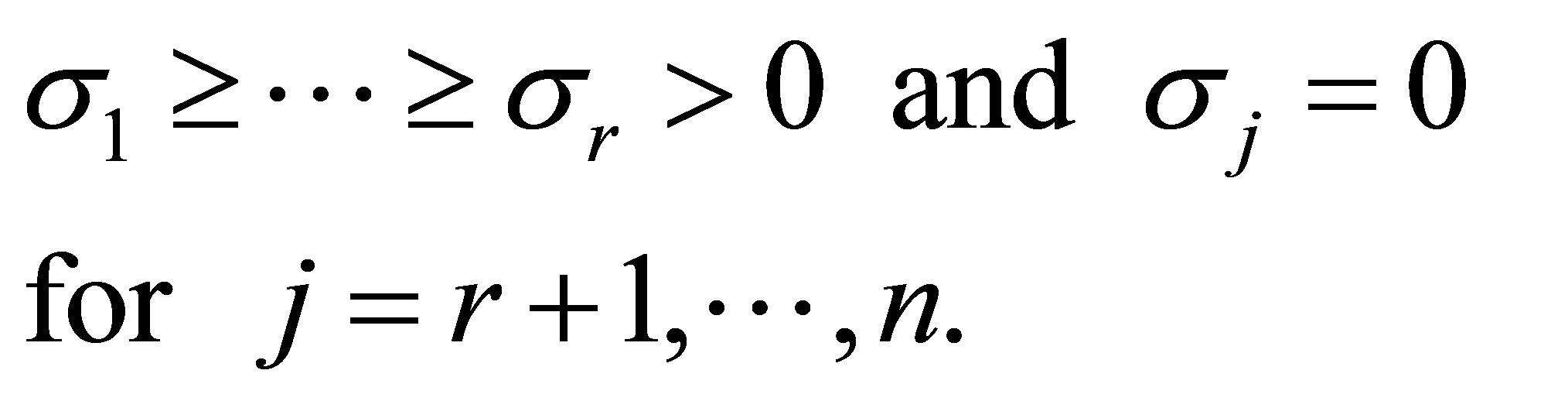

ماتریس مورب است. مقادیر منحصر به فرد ![]() فرض می شود که منفی نبوده و برای ارضای آن مرتب شده باشد

فرض می شود که منفی نبوده و برای ارضای آن مرتب شده باشد

![]() (2.2)

(2.2)

ستون از ![]() و

و ![]() به نام به سمت چپ بردار منحصر به فرد و بردار منحصر به فرد راست، به ترتیب. این بردارها با معادلات مرتبط هستند

به نام به سمت چپ بردار منحصر به فرد و بردار منحصر به فرد راست، به ترتیب. این بردارها با معادلات مرتبط هستند

![]() (2.3)

(2.3)

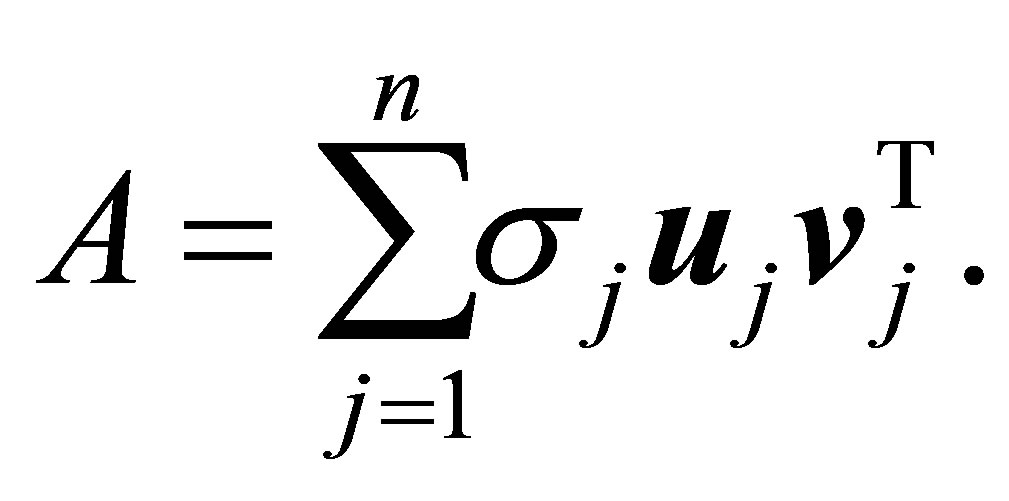

نتیجه بعدی (2.1) برابری است

(2.4)

(2.4)

علاوه بر این ، اجازه دهید ![]() نشان می دهد رتبه از

نشان می دهد رتبه از ![]() . سپس ، به وضوح ،

. سپس ، به وضوح ،

(2.5)

(2.5)

بنابراین (2.4) را می توان دوباره نوشت

(2.6)

(2.6)

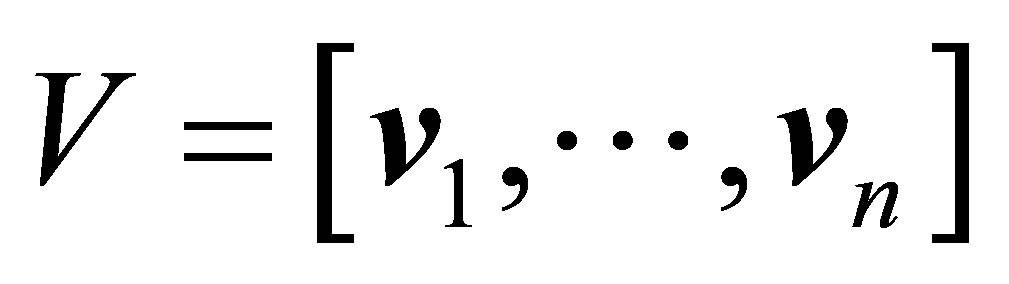

اجازه دهید ماتریس ها

(2.7)

(2.7)

به ترتیب از اولین ![]() ستون های U ساخته شده

ستون های U ساخته شده ![]() است. اجازه دهید

است. اجازه دهید  یک

یک ![]() ماتریس مورب باشد. سپس ماتریس

ماتریس مورب باشد. سپس ماتریس

(2.8)

(2.8)

![]() مرتبه- SVD کوتاه شده از نامیده می شود

مرتبه- SVD کوتاه شده از نامیده می شود ![]() .

.

اجازه دهید  ، به ترتیب

، به ترتیب ![]() ورودی های ماتریس را

ورودی های ماتریس را  مشخص کنید. سپس (2.4) نشان می دهد که

مشخص کنید. سپس (2.4) نشان می دهد که

(2.9)

(2.9)

و

(2.10)

(2.10)

که در آن آخرین نابرابری زیر از نابرابری CauchySchwarz و این واقعیت است که ستون از ![]() و

و ![]() باید طول واحد.

باید طول واحد.

یکی دیگر از ویژگیهای مفید مفاهیم بزرگنمایی و هنجارهای یکپارچه بی ثبات است. به یاد بیاورید که در صورت برابر بودن یک هنجار ماتریس ![]() به

به ![]() صورت واحد تغییر نمی کند

صورت واحد تغییر نمی کند

![]() (2.11)

(2.11)

برای هر ماتریس  و هر جفت ماتریس واحد راضی هستند

و هر جفت ماتریس واحد راضی هستند  و

و  . اجازه دهید

. اجازه دهید ![]() و

و ![]() یک جفت

یک جفت ![]() ماتریس داده شده با مقادیر منفرد باشد

ماتریس داده شده با مقادیر منفرد باشد

به ترتیب. اجازه دهید  و

و

معنی مربوطه ![]() -vectors از ارزش منحصر به فرد. سپس رابطه بزرگ نمایی ضعیف

-vectors از ارزش منحصر به فرد. سپس رابطه بزرگ نمایی ضعیف  به این معنی است که این بردارها نابرابری ها را برآورده می کنند

به این معنی است که این بردارها نابرابری ها را برآورده می کنند

(2.12)

(2.12)

در این حالت می گوییم که ![]() توسط ضعیف بزرگ شده

توسط ضعیف بزرگ شده ![]() یا مقادیر منفرد B به طور ضعیفی توسط آن بزرگ شده است

یا مقادیر منفرد B به طور ضعیفی توسط آن بزرگ شده است ![]() . قضیه تسلط Ky Fan [ 11 ] این دو مفهوم را با هم مرتبط می کند. این مقاله می گوید اگر مقادیر منفرد

. قضیه تسلط Ky Fan [ 11 ] این دو مفهوم را با هم مرتبط می کند. این مقاله می گوید اگر مقادیر منفرد ![]() توسط آن

توسط آن ![]() نابرابری بزرگ شود

نابرابری بزرگ شود

![]() (2.13)

(2.13)

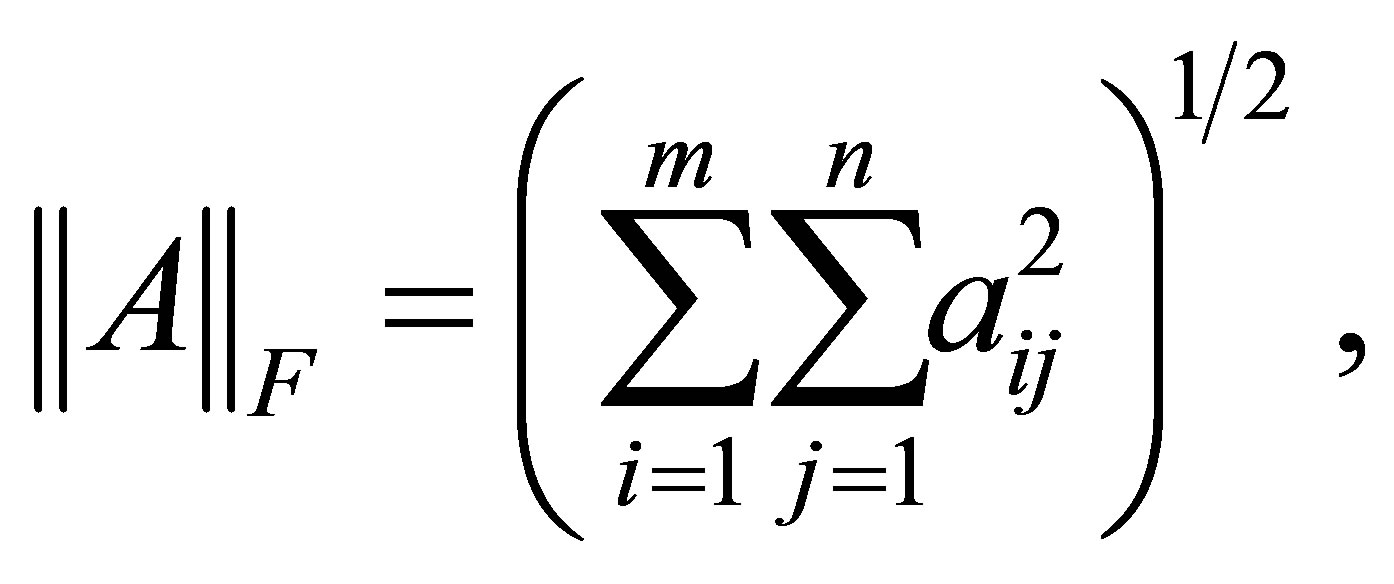

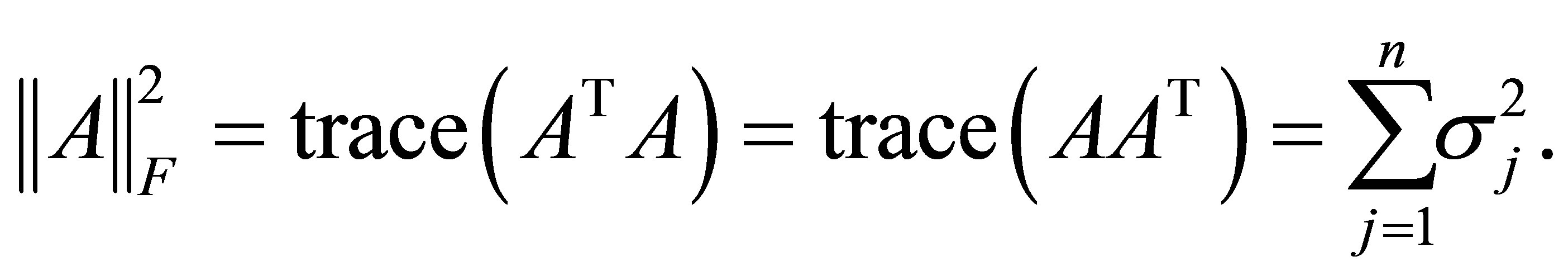

برای هر هنجار واحدی ثابت است. برای اثبات دقیق این واقعیت ، به عنوان مثال ، [1،11،17،22] را ببینید. مشهورترین مثال از یک هنجار منحصر به فرد ، شاید هنجار ماتریس Frobenius است

(2.14)

(2.14)

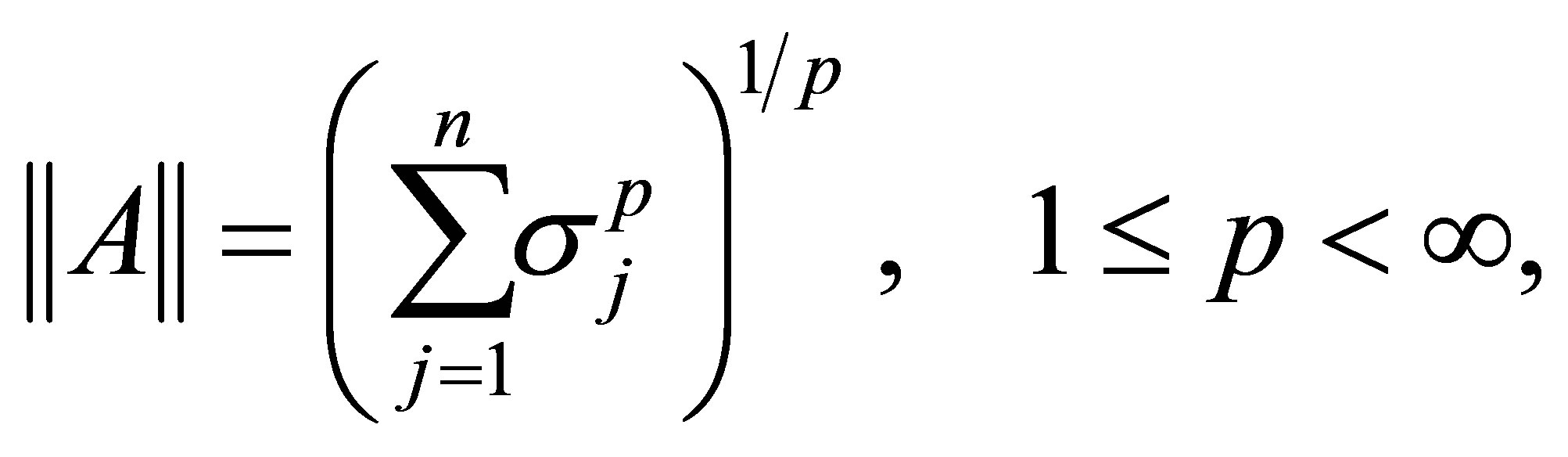

که راضی می کند

(2.15)

(2.15)

مثالهای دیگر Schatten ![]() -norms است ،

-norms است ،

(2.16)

(2.16)

و Ky Fan ![]() -norms ،

-norms ،

(2.17)

(2.17)

هنجار کمیاب ،

(2.18)

(2.18)

برای ![]() و

و ![]() در حالی که هنجار طیفی (2 هنجار) بدست می آید

در حالی که هنجار طیفی (2 هنجار) بدست می آید

![]() (2.19)

(2.19)

مطابقت دارد ![]() و

و  .

.

در آخر ، اجازه دهید ![]() و

و ![]() یک جفت عدد صحیح مثبت داشته باشید ، به گونه ای که

یک جفت عدد صحیح مثبت داشته باشید ، به گونه ای که

سپس

(2.20)

(2.20)

و

(2.21)

(2.21)

منیفولدهای مربوط به استیفل را نشان می دهد. یعنی ![]() مجموعه ای از تمام

مجموعه ای از تمام ![]() ماتریس های واقعی با ستون های متعادل ، در حالی

ماتریس های واقعی با ستون های متعادل ، در حالی ![]() که مجموعه تمام

که مجموعه تمام ![]() ماتریس های واقعی با ستون های متعادل است.

ماتریس های واقعی با ستون های متعادل است.

منبع

https://file.scirp.org/Html/2-5300515_41122.htm

پیشرفت در ریاضیات خالص

جلد 3 شماره 9 B (2013) ، شناسه مقاله: 41122،17 صفحه DOI: 10.4236 / apm.2013.39A2002

از مقادیر ویژه تا مقادیر واحد: یک بررسی

خدمات هیدرولوژیکی ، اورشلیم ، اسرائیل

ایمیل: dax20@water.gov.il

کپی رایت © 2013 آکیا داکس. این یک مقاله دسترسی آزاد است که تحت مجوز Creative Commons Attribution توزیع شده است ، استفاده ، توزیع و تولید مثل بدون محدودیت در هر رسانه را مجاز می داند ، به شرط آنکه اثر اصلی به درستی ذکر شود.

دریافت شده در 15 آگوست 2013؛ تجدید نظر شده در 15 سپتامبر 2013 ؛ 21 سپتامبر 2013 پذیرفته شده است

کلمات کلیدی: مقادیر ویژه؛ مقادیر واحد ؛ Rayleigh Quotient؛ ماتریس های ضریب متعامد؛ برابری فاکتورهای متعامد؛ قضیه اكارت-یانگ؛ اصول Extremum Ky Fan

چکیده

تشابه بین مقادیر ویژه و مقادیر واحد چهره های بسیاری دارد. بررسی کنونی چندین نمونه از این تشبیه را گرد هم آورده است. یک مثال مربوط به شباهت بین مقدارهای ریلی متقارن و مقدارهای ریلی مستطیل است. بسیاری از خواص مفید ساقه مقادیر ویژه از قضیه مینیماکس Courant-Fischer ، از قضیه Weyl ، و نتیجه آن است. جنبه دیگر مربوط به نسخه های "مستطیلی" این قضیه ها است. مقایسه خصوصیات ماتریس های Rayleigh Quotient با ماتریس های Orthogonal Quotient موضوع را در نور جدید روشن می کند. برابری ضرایب متعامد یک نتیجه اخیر است که مسئله حداقل هنجار اكارت-یانگ را به مسئله حداكثر هنجار معادل تبدیل می كند. این مسئله پیوند شگفت انگیزی بین قضیه اكارت-یانگ و حداكثر اصل Ky Fan را آشكار می كند. می بینیم که این دو قضیه دو روی یک سکه را منعکس می کنند: اصل حداکثر کلی تری وجود دارد که هر دو قضیه به راحتی از آن گرفته می شوند. Ky Fan از اصل extremeum خود (در مورد ردیابی ماتریس ها) برای استخراج نتایج آنالوگ در تعیین ماتریس های مثبت Rayleigh Quotients استفاده کرده است. اصل جدید extremeum این نتایج را به ماتریس های مستطیل مستطیل گسترش می دهد. آوردن همه این موضوعات زیر یک سقف ، بینش جدیدی در مورد روابط جذاب بین مقادیر ویژه و ارزشهای منفرد فراهم می کند.

1. مقدمه

اجازه دهید ![]() یک

یک ![]() ماتریس متقارن واقعی باشد و اجازه دهید

ماتریس متقارن واقعی باشد و اجازه دهید

یک بردار غیر صفر داده شده باشد. سپس شناخته شده Rayleigh Quotient به این صورت تعریف می شود

یک بردار غیر صفر داده شده باشد. سپس شناخته شده Rayleigh Quotient به این صورت تعریف می شود

![]() (1.1)

(1.1)

یکی از انگیزه های این تعریف در مشاهده زیر نهفته است. بگذارید ![]() یک عدد واقعی داده شود. سپس ارزش ویژه

یک عدد واقعی داده شود. سپس ارزش ویژه ![]() ای از آن وجود دارد به

ای از آن وجود دارد به ![]() گونه ای که

گونه ای که

![]() (1.2)

(1.2)

و مقدار ![]() آن مسئله حداقل هنجار را حل می کند

آن مسئله حداقل هنجار را حل می کند

![]() (1.3)

(1.3)

توسط داده شده است ![]() . به عبارت دیگر ،

. به عبارت دیگر ، ![]() برآورد ارزش ویژه مربوط به آن را ارائه می دهد

برآورد ارزش ویژه مربوط به آن را ارائه می دهد ![]() . ترکیب این برآورد با تکرار معکوس باعث تکرار تکرار مقدار ریلی می شود. از دیگر ویژگیهای مرتبط می توان به نابرابری های مینیمکس Courant-Fischer ، قضیه یکنواختی ویل و بسیاری دیگر از نتایج ناشی از این مشاهدات اشاره کرد. به طور خاص ، بزرگترین و کوچکترین مقادیر ویژه برای

. ترکیب این برآورد با تکرار معکوس باعث تکرار تکرار مقدار ریلی می شود. از دیگر ویژگیهای مرتبط می توان به نابرابری های مینیمکس Courant-Fischer ، قضیه یکنواختی ویل و بسیاری دیگر از نتایج ناشی از این مشاهدات اشاره کرد. به طور خاص ، بزرگترین و کوچکترین مقادیر ویژه برای ![]() ارضای

ارضای

![]() (1.4)

(1.4)

و

![]() (1.5)

(1.5)

به ترتیب. برای بحث دقیق در مورد مقدار ریلی و خصوصیات آن ، به عنوان مثال ، [1-41] را ببینید.

س thatالی که مطالعه ما را آغاز می کند این است که چگونه تعریف Rayleigh Quotient را برای تخمین مقدار منفرد یک ماتریس مستطیل شکل عمومی گسترش دهیم ، جایی که اصطلاح "مستطیل شکل" به این معنی است که ماتریس لزوماً متقارن یا مربع نیست. به عبارت دقیق تر ، اجازه دهید ![]() یک

یک ![]() ماتریس واقعی باشد

ماتریس واقعی باشد  ، و اجازه دهید

، و اجازه دهید  و

و  یک جفت بردار غیر صفر باشد. سپس ما به دنبال یک تابع اسکالر هستیم

یک جفت بردار غیر صفر باشد. سپس ما به دنبال یک تابع اسکالر هستیم![]() ، و

، و ![]() ،

،  مثلاً ، مقدار آنها تقریباً با ارزش مفرد "متناظر" برابر است

مثلاً ، مقدار آنها تقریباً با ارزش مفرد "متناظر" برابر است ![]() . پاسخ توسط مستطیل مستطیل داده شده است ،

. پاسخ توسط مستطیل مستطیل داده شده است ،

![]() (1.6)

(1.6)

که  نشانگر هنجار بردار اقلیدسی است. توجیهات این تعریف در بخش 3 آورده شده است. در آنجا نشان داده شده است که خصوصیات مقدار مستطیل (1.6) به خصوصیات مقدار ریلی شباهت دارد (1.1). در واقع ، همانطور که بررسی ما نشان می دهد ، شباهت فوق یک قانون کلی تر را منعکس می کند: ویژگی های بهینه ماتریس های فاضلاب متعامد شبیه ماتریس های Rayleigh Quotient هستند (گسترش می یابند).

نشانگر هنجار بردار اقلیدسی است. توجیهات این تعریف در بخش 3 آورده شده است. در آنجا نشان داده شده است که خصوصیات مقدار مستطیل (1.6) به خصوصیات مقدار ریلی شباهت دارد (1.1). در واقع ، همانطور که بررسی ما نشان می دهد ، شباهت فوق یک قانون کلی تر را منعکس می کند: ویژگی های بهینه ماتریس های فاضلاب متعامد شبیه ماتریس های Rayleigh Quotient هستند (گسترش می یابند).

اجازه دهید  یک

یک ![]() ماتریس واقعی با باشد

ماتریس واقعی با باشد

![]() ستونهای عادی. بگذارید

ستونهای عادی. بگذارید  واقعی باشد

واقعی باشد

![]() ماتریس با

ماتریس با ![]() ستون های متعادل. سپس یک

ستون های متعادل. سپس یک ![]() ماتریس از فرم

ماتریس از فرم

![]() (1.7)

(1.7)

ماتریس Orthogonal Quotient نامیده می شود. توجه داشته باشید که

![]() (1.8)

(1.8)

بنابراین ورودی ها از ![]() مقدار مطلق برابر با ضریب های مستطیل مربوطه برخوردارند. ماتریس های فرم (1.7) را می توان ماتریس های Rayleigh Quotient "مستطیل شکل" دید. تعریف سنتی از ماتریس های متقارن Rayleigh Quitient به ماتریس های متقارن فرم اشاره دارد

مقدار مطلق برابر با ضریب های مستطیل مربوطه برخوردارند. ماتریس های فرم (1.7) را می توان ماتریس های Rayleigh Quotient "مستطیل شکل" دید. تعریف سنتی از ماتریس های متقارن Rayleigh Quitient به ماتریس های متقارن فرم اشاره دارد

![]() (1.9)

(1.9)

که در آن ![]() و

و ![]() تعریف همانطور که در بالا، به عنوان مثال، [20،30،36]. متریال های متقارن Rayleigh Quitient این فرم را بعضی اوقات مقطع می نامند. یک کلاس بزرگتر از ماتریس های Rayleigh Quotients در [ 34 ] در نظر گرفته شده است . این ماتریس ها فرم دارند

تعریف همانطور که در بالا، به عنوان مثال، [20،30،36]. متریال های متقارن Rayleigh Quitient این فرم را بعضی اوقات مقطع می نامند. یک کلاس بزرگتر از ماتریس های Rayleigh Quotients در [ 34 ] در نظر گرفته شده است . این ماتریس ها فرم دارند

![]() (1.10)

(1.10)

کجا ![]() یک ماتریس مربع عمومی (غیر عادی) از نظم وجود دارد

یک ماتریس مربع عمومی (غیر عادی) از نظم وجود دارد ![]() .

. ![]() ماتریس

ماتریس ![]() فرض بر این است به رتبه ستون کامل باشد، و

فرض بر این است به رتبه ستون کامل باشد، و ![]() ماتریس

ماتریس ![]() نشان دهنده یک معکوس چپ

نشان دهنده یک معکوس چپ ![]() . یعنی یک ماتریس راضی کننده

. یعنی یک ماتریس راضی کننده . ماتریس فرمها (1.9) و (1.10) نقش مهمی در روش ریلی-ریتز و در روشهای فضایی Krylov دارند ، به عنوان مثال ، [30،34]. در این زمینه ادبیات غنی در مورد مرزهای باقیمانده برای مقادیر ویژه و فضاهای ویژه وجود دارد. برای مثال ، به [19-21،30،32،34،36] مراجعه کنید. برنامه های دیگر ماتریس های Rayleigh Quotient در الگوریتم های بهینه سازی بوجود می آیند که سعی می کنند تقریب های خود را در یک منیفولد خاص Stiefel حفظ کنند ، به عنوان مثال ، [6،7،9،35].

. ماتریس فرمها (1.9) و (1.10) نقش مهمی در روش ریلی-ریتز و در روشهای فضایی Krylov دارند ، به عنوان مثال ، [30،34]. در این زمینه ادبیات غنی در مورد مرزهای باقیمانده برای مقادیر ویژه و فضاهای ویژه وجود دارد. برای مثال ، به [19-21،30،32،34،36] مراجعه کنید. برنامه های دیگر ماتریس های Rayleigh Quotient در الگوریتم های بهینه سازی بوجود می آیند که سعی می کنند تقریب های خود را در یک منیفولد خاص Stiefel حفظ کنند ، به عنوان مثال ، [6،7،9،35].

کلاس سوم ماتریس های Rayleigh Quotient از (1.7) با گرفتن بدست می آید  . این ماتریس ها در مرزهای باقیمانده برای مقادیر منفرد و فضاهای مجزا درگیر هستند ، به عنوان مثال ، [2،21].

. این ماتریس ها در مرزهای باقیمانده برای مقادیر منفرد و فضاهای مجزا درگیر هستند ، به عنوان مثال ، [2،21].

با این حال ، بررسی ما به جهات مختلف تبدیل می شود. هدف این است که خواص بهینه سازی ماتریس های ضریب متعامد را کشف کند. مقایسه این خصوصیات با ماتریس های متقارن Rayleigh Quotients مشاهدات بسیار جالبی را نشان می دهد. در قلب این مشاهدات رابطه تعجب آور بین قضیه حداقل هنجار اكارت-یانگ [ 5 ] و حداكثر اصل Ky Fan [ 10 ] وجود دارد.

قضیه اكارت-یانگ مسئله تقریب یك ماتریس با ماتریس دیگر با درجه پایین را در نظر می گیرد. راه حل این مشکل را نیز به اشمیت نسبت می دهند [ 31] به [17 ، pp. 137،138 ~] و [33 ، p. 76] مراجعه کنید. نیاز به تقریب های سطح پایین یک ماتریس یک مشکل اساسی است که در بسیاری از برنامه ها بوجود می آید ، به عنوان مثال [3-5،8،14،15،18،33]. حداکثر اصل Ky Fan مسئله به حداکثر رساندن ردیابی یک ماتریس متقارن Rayleigh Quotient را در نظر می گیرد. همچنین یک نتیجه کاملاً شناخته شده است که کاربردهای بسیاری دارد ، به عنوان مثال ، [1،10-12 ، 16،22،28]. با این حال ، تاکنون ، این دو قضیه همیشه به عنوان نتایج مستقل و غیر مرتبط در نظر گرفته شده اند که مبتنی بر استدلال های مختلف هستند. برابری ضرایب متعامد یک نتیجه اخیر است که مسئله حداقل هنجار EckartYoung را به یک مسئله حداکثر هنجار معادل تبدیل می کند. این شباهت شگفت آور بین قضیه اكارت-یانگ و حداكثر اصل Ky Fan را آشكار می كند. می بینیم که این دو قضیه دو روی یک سکه را منعکس می کنند: یک قاعده حداکثر کلی تری وجود دارد که هر دو قضیه به راحتی از آن گرفته می شوند.

طرح بررسی ما به شرح زیر است. این کار با معرفی برخی نکات و حقایق ضروری آغاز می شود. سپس مشخص می شود که خصوصیات اساسی مقدار مستطیل (1.6) را نشان می دهد ، نشان می دهد که تعدادی از کمترین مشکلات نرمال شبیه به 1.3 را حل می کند. یک خطای محدود شده ، شبیه به (1.2) ، ما را قادر می سازد فاصله بین ![]() و نزدیکترین مقدار منفرد را محدود کنیم

و نزدیکترین مقدار منفرد را محدود کنیم ![]() .

.

جنبه دیگری از تشبیه بین مقادیر ویژه و مقادیر واحد در بخش 4 بررسی شده است ، که در آن نسخه های "مستطیلی" قضیه مینیمکس Courant-Fischer و قضیه Weyl را در نظر می گیریم. این راه را برای اثبات "سنتی" قضیه اكارت-یانگ هموار می كند. سپس با استفاده از قضیه تسلط Ky Fan می توان قضیه میرسکی را نتیجه گرفت.

رابطه بین ماتریس های متقارن Rayleigh Quotient و ماتریس های Orthogonal Quotients در بخش 5 مطالعه شده است. در آنجا نشان داده شده است که کمترین خصوصیات مربعات ماتریس های Orthogonal Quotient شبیه ماتریس های متقارن Rayleigh-Quotient است. یکی از پیامدهای این خصوصیات برابری ضرایب متعامد است که در بخش 6 استخراج شده است. همانطور که در بالا ذکر شد ، این برابری مسئله حداقل مربعات اكارت-یانگ را به حداكثر مسئله معادل تبدیل می كند ، كه تلاش می كند تا هنجار Frobenius از ماتریس عناصر متعامد را به حداكثر برساند فرم (1.7).

نسخه متقارن برابری فاکتورهای متعامد مسئله به حداکثر رساندن (یا به حداقل رساندن) ردپای ماتریس های متقارن رله را در نظر می گیرد. راه حل این مشکلات توسط اصول افراطی Ky Fan ارائه شده است. شباهت بین حداکثر شکل قضیه اكارت-یانگ و حداكثر اصل Ky Fan نشان می دهد كه هر دو مشاهده موارد خاصی از یك اصل افراطی كلی تر هستند. استنباط این اصل در بخش 8 انجام شده است. در آنجا نشان داده شده است که هر دو نتیجه از اصل حداکثر توسعه یافته به راحتی نتیجه می گیرند.

بررسی با بحث درباره برخی عواقب اصل توسعه یافته پایان می یابد. یک نتیجه یک برابری حداکثر حداکثر است که مسئله حداقل هنجار میرسکی را با مسئله حداکثر توسعه یافته مرتبط می کند. نوع دوم پیامدها مربوط به ردپای ماتریس های ضریب متعامد است. نتایج Ky Fan در مورد ردیابی ماتریس های متقارن ریلی [ 10 ] در مقالات اخیر وی [11،12] به محصولات مقادیر ویژه و عوامل تعیین شده گسترش یافت. اصل جدید extremeum گسترش این خصوصیات را به ماتریس های متعامد متعامد امکان پذیر می کند.

بررسی کنونی چندین نتیجه قدیمی و جدید را گرد هم آورده است. نتایج "قدیمی" با ارجاعات مناسب ارائه می شوند. در مقابل ، نتایج "جدید" بدون ارجاع به دست می آیند ، زیرا بیشتر آنها از مقاله تحقیقی اخیر [ 3 ] این نویسنده گرفته شده است. با این حال مقاله حاضر تعدادی از مشارکت ها را در بر می گیرد که در [ 3 ] موجود نیست. یک سهم در مورد گسترش قضیه 11 پشت هنجار Frobenius است. سهم دیگر حداقل و حداکثر برابری است که در بخش 9 معرفی شده است. تفاوت اصلی بین [ 3] و این مقاله در مفهوم آنها نهفته است. مقاله اول مقاله تحقیقی است که هدف آن ایجاد اصل گسترش افراطی است. این بررسی برخی از ویژگیهای جذاب تشبیه بین مقادیر ویژه و مقادیر واحد را نشان می دهد. برای این منظور ما چندین نتیجه ظاهرا غیر مرتبط را ارائه می دهیم. قرار دادن همه این مباحث در زیر یک سقف دید بهتری نسبت به این روابط دارد. توصیف نتایج بر روی ماتریس ها و بردارهای با ارزش واقعی متمرکز می شود. این کار ارائه را ساده می کند و به تمرکز بر ایده های اصلی کمک می کند. درمان این مورد باارزش کاملاً واضح است.

منبع

https://file.scirp.org/Html/2-5300515_41122.htm

از ویکیپدیا، دانشنامه آزاد

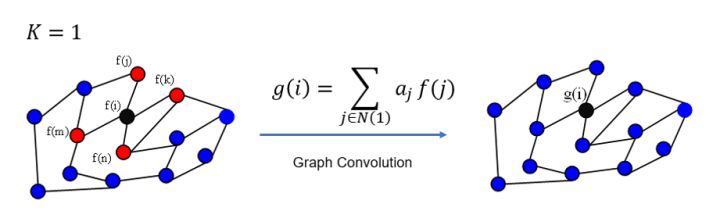

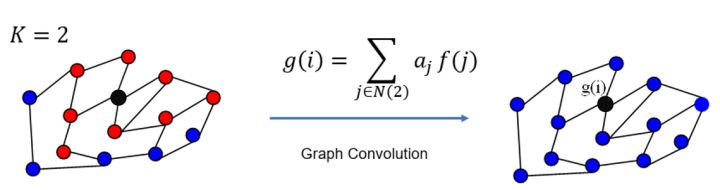

در تجزیه و تحلیل عددی ، تکرار معکوس (همچنین به عنوان روش توان معکوس شناخته می شود ) یک الگوریتم تکرار ارزش ویژه است . هنگامی که تقریب با مقدار ویژه مربوطه شناخته شده باشد به شما امکان می دهد یک بردار ویژه تقریبی پیدا کنید . این روش از نظر مفهومی مشابه روش قدرت است . به نظر می رسد که در اصل برای محاسبه فرکانس های تشدید در زمینه مکانیک سازه ساخته شده است. [1]

الگوریتم تکرار توان معکوس با یک تقریب شروع می شود

جایی که

در هر تکرار ، بردار

ایده اصلی تکرار قدرت انتخاب بردار اولیه است

تکرار معکوس همین کار را برای ماتریس انجام می دهد

نتیجه گیری : این روش به بردار ویژه ماتریس همگرا می شود

به ویژه ، گرفتن

اجازه دهید میزان همگرایی روش را تجزیه و تحلیل کنیم .

روش قدرت شناخته شده است به همگرا خطی به حد، دقیق تر:

از این رو برای روش تکرار معکوس نتیجه مشابه به نظر می رسد:

این یک فرمول کلیدی برای درک همگرایی روش است. نشان می دهد که اگر

الگوریتم تکرار معکوس نیاز به حل یک سیستم خطی یا محاسبه ماتریس معکوس دارد. برای ماتریس های غیر ساختاری (نه پراکنده ، نه Toeplitz ، ...) این نیاز دارد

روش با فرمول تعریف شده است:

با این وجود گزینه های متعددی برای اجرای آن وجود دارد.

ما می توانیم فرمول را به روش زیر بازنویسی کنیم:

با تأکید بر اینکه برای پیدا کردن تقریب بعدی

این انتخاب به تعداد تکرارها نیز بستگی دارد. ساده لوحانه ، اگر در هر تکرار یک سیستم خطی حل شود ، پیچیدگی k * O (n 3 ) خواهد بود ، جایی که k تعداد تکرار است. به طور مشابه ، محاسبه ماتریس معکوس و استفاده از آن در هر تکرار از پیچیدگی k * O (n 3 ) است . البته توجه داشته باشید که در صورت تخمین مقدار ویژه

معکوس کردن ماتریس معمولاً هزینه اولیه بیشتری دارد ، اما در هر تکرار هزینه کمتری دارد. برعکس ، حل سیستم معادلات خطی معمولاً هزینه اولیه کمتری دارد ، اما برای هر تکرار به عملیات بیشتری احتیاج دارد.

اگر انجام بسیاری از تکرارها (یا تکرارهای کم ، اما برای بسیاری از بردارهای ویژه) ضروری باشد ، ممکن است عاقلانه باشد که ابتدا ماتریس را به شکل بالایی هسنبرگ بیاورید (برای ماتریس متقارن این حالت سه ضلعی خواهد بود ). که هزینه دارد

حل سیستم معادلات خطی برای هزینه های ماتریس سه وجهی

همچنین تبدیل به فرم هسنبرگ شامل ریشه های مربع و عمل تقسیم است که به طور جهانی توسط سخت افزار پشتیبانی نمی شوند.

[ ویرایش ]

[ ویرایش ]در پردازنده های هدف عمومی (به عنوان مثال تولید شده توسط اینتل) زمان اجرای جمع ، ضرب و تقسیم تقریباً برابر است. اما در سخت افزارهای جاسازی شده و / یا کم مصرف انرژی ( پردازنده های سیگنال دیجیتال ، FPGA ، ASIC ) بخش ممکن است توسط سخت افزار پشتیبانی نشود ، بنابراین باید از آن اجتناب شود. انتخاب کردن

هنگام اجرای الگوریتم با استفاده از حساب نقطه ثابت ، انتخاب ثابت است

کاربرد اصلی روش شرایطی است که تقریب با مقادیر ویژه پیدا شود و یکی نیاز به پیدا کردن بردار ویژه تقریبی داشته باشد. در چنین شرایطی تکرار معکوس اصلی ترین و احتمالاً تنها روش استفاده است.

به طور معمول ، این روش در ترکیب با روش دیگری مورد استفاده قرار می گیرد که مقادیر ویژه تقریبی را پیدا می کند: مثال استاندارد الگوریتم مقادیر ویژه مقطعی است ، مثال دیگر تکرار ضریب ریلی است که در واقع همان تکرار معکوس با انتخاب مقادیر ویژه تقریبی است ضریب ریلی مربوط به بردار بدست آمده در مرحله قبلی تکرار است.

برخی شرایط وجود دارد که روش می تواند به تنهایی مورد استفاده قرار گیرد ، اما کاملاً حاشیه ای است.

ارزش ویژه غالب را می توان به راحتی برای هر ماتریسی تخمین زد. برای هر هنجار القایی این درست است

در برخی از برنامه های زمان واقعی ، لازم است بردارهای ویژه ماتریس هایی با سرعت میلیون ها ماتریس در ثانیه پیدا شود. در چنین برنامه هایی ، به طور معمول آمار ماتریس ها از قبل مشخص است و می توان برای مقادیر ویژه تقریبی ، مقادیر ویژه تقریبی ویژه برخی از نمونه های ماتریس بزرگ را در نظر گرفت. بهتر است ، کسي بتواند نسبت متوسط مقادير ويژه به رديف يا هنجار ماتريس را محاسبه كرده و ميانگين ارزش ويژه را به عنوان رديف يا هنجار ضرب در ميانگين مقدار آن نسبت تخمين بزند. بدیهی است که چنین روشی تنها با صلاحدید و تنها در مواردی که دقت بالا از اهمیت بالایی برخوردار نباشد ، قابل استفاده است. این روش تخمین یک مقدار ویژه را می توان با روشهای دیگر ترکیب کرد تا از خطای بیش از حد بزرگ جلوگیری شود.

https://en.wikipedia.org/wiki/Inverse_iteration

در ریاضیات ، تکرار توان (که به آن روش قدرت نیز گفته می شود ) یک الگوریتم ارزش ویژه است : با توجه به ماتریس مورب

تکرار نیرو یک الگوریتم بسیار ساده است ، اما ممکن است به آرامی همگرا شود. وقت گیرترین کار الگوریتم ضرب ماتریس است

انیمیشنی که الگوریتم تکرار توان را در ماتریس 2x2 تجسم می کند. ماتریس توسط دو بردار ویژه آن به تصویر کشیده شده است. خطا به عنوان محاسبه می شود

الگوریتم تکرار توان با بردار شروع می شود

بنابراین ، در هر تکرار ، بردار

اگر فرض کنیم

بدون دو فرض بالا ، توالی

جایی که

با ارزش ویژه غالب همگرا می شود (با ضریب ریلی ). [ توضیحات لازم است ]

یکی می تواند این را با الگوریتم زیر محاسبه کند (در پایتون با NumPy نشان داده شده است):

#! / usr / bin / env python3

وارد کردن numpy به عنوان np

دف power_iteration ( ، num_simulations : INT ): # در حالت ایده آل را انتخاب نمایید یک بردار تصادفی # برای کاهش شانس است که بردار # متعامد به بردارهای ویژه است b_k = NP . تصادفی . رند ( . شکل [ 1 ])

for _ in range ( num_simulations ):

# محاسبه محصول ماتریس توسط بردار Ab

b_k1 = np . نقطه ( A ، b_k )

# محاسبه هنجار

b_k1_norm = np . linalg . هنجار ( b_k1 )

# بردار

b_k = b_k1 / b_k1_norm را عادی کنید

بازگشت b_k

power_iteration ( NP . آرایه ([[ 0.5 ، 0.5 ]، [ 0.2 ، 0.8 ]])، 10 )

بردار

این الگوریتم برای محاسبه Google PageRank استفاده می شود .

از این روش می توان برای محاسبه شعاع طیفی (مقدار ویژه با بیشترین اندازه برای ماتریس مربع) با محاسبه ضریب Rayleigh استفاده کرد.

اجازه دهید

![{\ displaystyle [\ lambda _ {1}] ،}](https://wikimedia.org/api/rest_v1/media/math/render/svg/0f3c83a8bae265cd5523c330d3b5f9901fee6ab0)

با فرض ،

رابطه عود محاسباتی مفید برای

که در آن عبارت:

عبارت فوق ساده به صورت

این حد از این واقعیت حاصل می شود که مقدار ویژه از

نتیجه می شود که:

با استفاده از این واقعیت ،

جایی که

تسلسل و توالی

متناوباً ، اگر A قابل مورب باشد ، اثبات زیر همان نتیجه را دارد

اجازه دهید λ 1 ، λ 2 ، ...، λ متر باشد متر مقادیر ویژه (شمارش، با تعدد) از و اجازه دهید V 1 ، V 2 ، ...، V متر باشد بردارهای ویژه مربوطه. فرض کنید که

بردار اولیه

اگر

از سوی دیگر:

از این رو،

جایی که

اگرچه روش تکرار نیرو فقط یک مقدار ویژه از یک ماتریس را تقریب می زند ، اما برای برخی از مشکلات محاسباتی همچنان مفید است . به عنوان مثال ، Google از آن برای محاسبه اسناد PageRank در موتور جستجوی خود استفاده می کند [2] و توییتر از آن برای نشان دادن توصیه های کاربران به دنبال استفاده از آنها استفاده می کند. [3] روش تکرار توان به ویژه برای ماتریس های پراکنده ، مانند ماتریس وب ، یا به عنوان روش بدون ماتریس که نیازی به ذخیره ماتریس ضریب نیست ، مناسب است.

برخی از الگوریتم های پیشرفته ارزش ویژه پیشرفته تر را می توان به عنوان تغییرات تکرار توان درک کرد. به عنوان مثال ، روش تکرار معکوس تکرار توان را به ماتریس اعمال می کند

منبع

https://en.wikipedia.org/wiki/Power_iteration

تکرار ضریب ریلی یک الگوریتم ارزش ویژه است که ایده تکرار معکوس را با استفاده از ضریب ریلی برای بدست آوردن برآورد دقیق تر از ارزش ویژه گسترش می دهد .

تکرار ضریب ریلی یک روش تکراری است ، یعنی توالی از راه حل های تقریبی را ارائه می دهد که در یک حد واقعی به یک محلول واقعی همگرا می شوند . همگرایی بسیار سریع تضمین شده است و برای به دست آوردن تقریب منطقی در عمل بیش از چند تکرار لازم نیست. ریلی خارج قسمت تکرار الگوریتم همگرا cubically برای هرمیتی یا متقارن ماتریس، با توجه به بردار اولیه این است که به اندازه کافی نزدیک به یک بردار ویژه از ماتریس است که در حال تجزیه و تحلیل.

الگوریتم شباهت زیادی به تکرار معکوس دارد ، اما مقدار ویژه برآورد شده در پایان هر تکرار را با ضریب ریلی جایگزین می کند. با انتخاب مقداری شروع کنید

تقریب بعدی بردار ویژه را محاسبه کنید

جایی که

برای محاسبه بیش از یک مقدار ویژه ، الگوریتم را می توان با یک روش تورم ترکیب کرد.

توجه داشته باشید که برای مشکلات بسیار کوچک ، جایگزینی ماتریس معکوس با مواد افزودنی مفید است ، که همان تکرار را ارائه می دهد زیرا برابر با معکوس تا مقیاس بی ربط است (معکوس تعیین کننده ، به طور خاص). صحیح محاسبه صریح از معکوس آسان تر است (اگرچه معکوس برای بردارهایی برای مسائلی که کوچک نیستند نیز به راحتی قابل استفاده است) ، و از نظر عددی کاملاً صحیح است زیرا به عنوان همگرایی مقدار ویژه به خوبی تعریف می شود.

ماتریس را در نظر بگیرید

که مقادیر ویژه دقیق آن است

![v_ {2} = \ چپ [{\ start {matrix} 1 \\ - \ varphi \\ 1 \\\ end {matrix}} \ right]](https://wikimedia.org/api/rest_v1/media/math/render/svg/f214dbe77c8e1a2e8115416b0933c3f26a92a12e)

![v_ {3} = \ چپ [{\ start {matrix} 1 \\ 0 \\ 1 \\\ end {matrix}} \ right]](https://wikimedia.org/api/rest_v1/media/math/render/svg/cc3ee9506136cc3a5c0c1828eb695ed4a0a93d3a)

(جایی که

بزرگترین ارزش ویژه است

ما با حدس اولیه ارزش ویژه از شروع می کنیم

![b_ {0} = \ left [{\ start {matrix} 1 \\ 1 \\ 1 \\\ end {matrix}} \ right]، ~ \ mu _ {0} = 200](https://wikimedia.org/api/rest_v1/media/math/render/svg/94e8b5982dd8f14b9671a20b7b1691f1efb7a04c)

سپس ، تکرار اول بازده دارد

تکرار دوم ،

و سوم ،

که از آن همگرایی مکعبی مشهود است.

function x = rayleigh(A, epsilon, mu, x)

x = x / norm(x);

% the backslash operator in Octave solves a linear system

y = (A - mu * eye(rows(A))) \ x;

lambda = y' * x;

mu = mu + 1 / lambda

err = norm(y - lambda * x) / norm(y)

while err > epsilon

x = y / norm(y);

y = (A - mu * eye(rows(A))) \ x;

lambda = y' * x;

mu = mu + 1 / lambda

err = norm(y - lambda * x) / norm(y)

end

endمنبع

https://en.wikipedia.org/wiki/Rayleigh_quotient_iteration

از ویکیپدیا، دانشنامه آزاد

در ریاضیات ، در خارج قسمت رایلی [1] برای یک مجموعه داده ماتریس هرمیتی M و غیر صفر بردار X است تعریف می شود: [2] [3]

برای ماتریس ها و بردارهای واقعی ، شرایط هرمیتی بودن به متقارن بودن کاهش می یابد و مزدوج جابجا می شود

برای بدست آوردن مقادیر دقیق تمام مقادیر ویژه از ضریب Rayleigh در قضیه min-max استفاده می شود . همچنین برای بدست آوردن تقریب مقدار ویژه از تقریب بردار ویژه در الگوریتم های ارزش ویژه (مانند تکرار ضریب Rayleigh ) استفاده می شود.

دامنه ضریب Rayleigh (برای هر ماتریسی ، نه لزوماً Hermitian) یک محدوده عددی نامیده می شود و شامل طیف آن است . وقتی ماتریس هرمیتی باشد ، محدوده عددی برابر با هنجار طیفی است. هنوز در تجزیه و تحلیل عملکرد ،

در مکانیک کوانتوم ، ضریب Rayleigh مقدار انتظار قابل مشاهده مربوط به عملگر M را برای سیستمی که حالت آن با x داده می شود ، می دهد .

اگر ماتریس پیچیده M را برطرف کنیم ، پس از آن نقشه مقدار ریلی (که تابعی از x در نظر گرفته می شود ) M را از طریق هویت قطبش کاملاً تعیین می کند . در واقع ، این درست می ماند حتی اگر اجازه دهیم M غیر هرمیتی باشد. (با این حال، اگر ما محدود زمینه اسکالرهای به اعداد حقیقی، سپس خارج قسمت رایلی تنها تعیین متقارن بخشی از M .)

[ ویرایش ]

[ ویرایش ]همانطور که در مقدمه بیان شد ، برای هر بردار x ، یکی دارد![R (M ، x) \ در \ چپ [\ lambda _ {\ min} ، \ lambda _ {\ max} \ راست]](https://wikimedia.org/api/rest_v1/media/math/render/svg/3367126b01f5e7829818dc7726de621c12767dd3)

جایی که

این واقعیت که ضریب یک میانگین وزنی از مقادیر ویژه است می تواند برای شناسایی مقادیر ویژه دوم ، سوم ، ... استفاده شود. اجازه دهید

یک ماتریس کوواریانس تجربی

اول اینکه مقادیر ویژه است

ثانیاً ، بردارهای ویژه

اگر مقادیر ویژه متفاوت باشد - در صورت تعدد ، می توان اساس را متعامد کرد.

برای اینکه ثابت کنید که ضریب ریلی توسط بردار ویژه با بیشترین مقدار ویژه به حداکثر می رسد ، تجزیه یک بردار دلخواه را در نظر بگیرید

جایی که

مختصات است

که، به orthonormality از بردارهای ویژه، می شود:

آخرین نمایش مشخص می کند که ضریب ریلی مجموع کسینوس های مربع زاویه های تشکیل شده توسط بردار است

اگر بردار باشد

تعریف کردن:

بنابراین ، ضریب ریلی توسط بردار ویژه با بیشترین مقدار ویژه به حداکثر می رسد.

متناوباً ، با روش ضرب لاگرانژ می توان به این نتیجه رسید . قسمت اول نشان می دهد که مقدار تحت ثابت مقیاس بندی ثابت است

به دلیل این عدم تحقق ، مطالعه مورد خاص کافی است

منوط به محدودیت

جایی که

و

بنابراین ، بردارهای ویژه

نظریه Sturm – Liouville مربوط به عملکرد عملگر خطی است

در فضای محصول داخلی تعریف شده توسط

توابع راضی برخی شرایط مرزی مشخص در a و b . در این حالت ضریب ریلی است

این گاهی اوقات به شکل معادل ارائه می شود که با جداسازی انتگرال در عدد و استفاده از ادغام توسط قطعات بدست می آید :

مقدار رایلی تعمیم یافته ریلی را می توان به مقدار ریلی کاهش داد

که با R ( H ، x ) همزمان می شود وقتی x = y . در مکانیک کوانتوم ، این کمیت را "عنصر ماتریس" یا گاهی "دامنه انتقال" می نامند.

https://en.wikipedia.org/wiki/Rayleigh_quotient

| 1 | 1 | 0 | 0 |

| 1 | 1 | 0 | 0 |

| 0 | 0 | 1 | 1 |

| 0 | 0 | 1 | 1 |

SECT(2,0,0,-2) طیف گراف

بردارهای ویژه:

| 1 |

| 1 |

| 1 |

| 1 |

| 1- |

| 1 |

| 0 |

| 0 |

| 0 |

| 0 |

| -1 |

| 1 |

| 1- |

| 1- |

| 1 |

| 1 |

ساختار جبری → نظریه گروه نظریه گروه

نمایش

مفاهیم اساسی

نمایش

گروههای محدود

نمایش گروه های گسسته مشبک

نمایش

گروه های توپولوژیک و لی

نمایش

گروه های جبری

گروه های لی

نمایش

گروه های کلاسیک

نمایش

گروه های ساده لی

نمایش

سایر گروه های لی

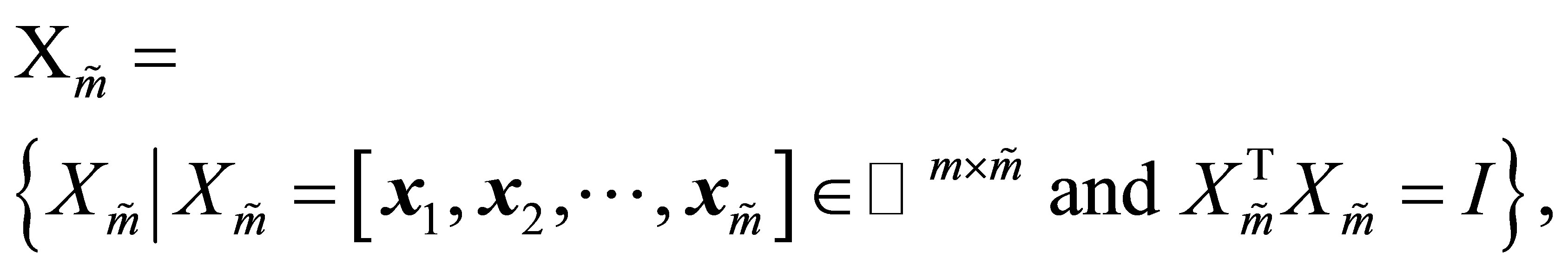

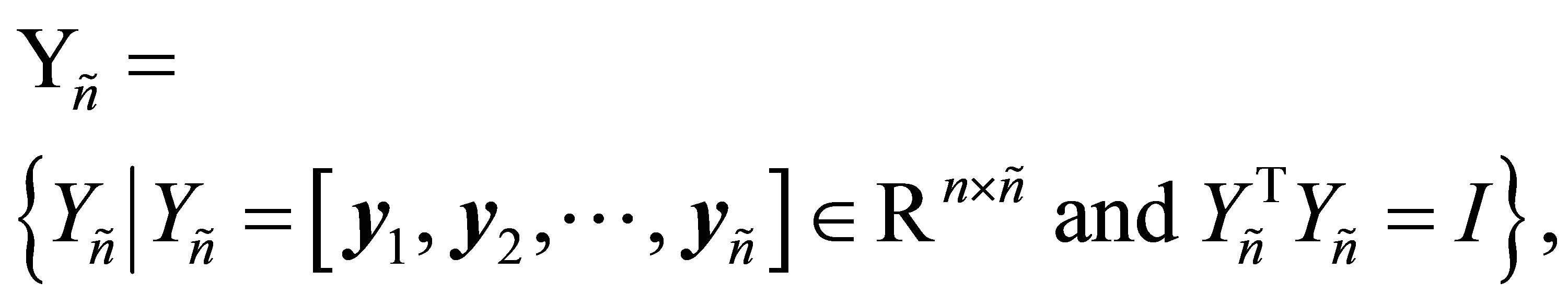

نمایش