2-کمترین مربعات

بیان مشکل [ ویرایش ]

هدف شامل تنظیم پارامترهای یک تابع مدل برای بهترین تناسب با یک مجموعه داده است. یک مجموعه داده ساده از n نقطه (جفت داده) تشکیل شده است.

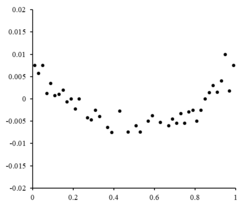

باقی مانده ها در برابر متناظر رسم می شوند

روش حداقل مربعات با به حداقل رساندن مجموع مجذور باقیمانده ، مقادیر پارامتر بهینه را پیدا می کند .

نمونه ای از یک مدل در دو بعدی مدل خط مستقیم است. نشان دادن قطع y به عنوان

یک نقطه داده ممکن است از بیش از یک متغیر مستقل تشکیل شده باشد. به عنوان مثال، هنگامی که یک هواپیما را به مجموعه ای از اندازه گیری های ارتفاع برازش می دهیم، صفحه تابعی از دو متغیر مستقل x و z است. در کلیترین حالت ممکن است یک یا چند متغیر مستقل و یک یا چند متغیر وابسته در هر نقطه داده وجود داشته باشد.

در سمت راست یک نمودار باقی مانده است که نوسانات تصادفی را نشان می دهد

باقی مانده ها در برابر مربوطه رسم می شوند

اگر نقاط باقیمانده دارای نوعی شکل بودند و به طور تصادفی در نوسان نبودند، یک مدل خطی مناسب نخواهد بود. به عنوان مثال، اگر نمودار باقیمانده یک شکل سهموی داشته باشد که در سمت راست دیده می شود، یک مدل سهموی

محدودیت ها [ ویرایش ]

این فرمول رگرسیون فقط خطاهای مشاهدهای را در متغیر وابسته در نظر میگیرد (اما رگرسیون مجموع حداقل مربعات جایگزین میتواند خطاها را در هر دو متغیر محاسبه کند). دو زمینه نسبتاً متفاوت با مفاهیم متفاوت وجود دارد:

- رگرسیون برای پیش بینی در اینجا یک مدل برای ارائه یک قانون پیشبینی برای کاربرد در موقعیت مشابهی که دادههای مورد استفاده برای برازش در آن اعمال میشود، برازش داده میشود. در اینجا، متغیرهای وابسته مربوط به چنین کاربردهای آتی، مشمول همان نوع خطای مشاهداتی هستند که در دادههای مورد استفاده برای برازش استفاده میشوند. بنابراین منطقاً استفاده از قانون پیشبینی حداقل مربعات برای چنین دادههایی سازگار است.

- رگرسیون برای تناسب یک "رابطه واقعی". در تجزیه و تحلیل رگرسیون استاندارد که منجر به برازش حداقل مربعات می شود، این فرض ضمنی وجود دارد که خطاهای متغیر مستقل صفر هستند یا به شدت کنترل می شوند تا ناچیز باشند. هنگامی که خطاهای متغیر مستقل غیر قابل چشم پوشی هستند، می توان از مدل های خطای اندازه گیری استفاده کرد. چنین روش هایی می تواند منجر به تخمین پارامترها ، آزمون فرضیه ها و فواصل اطمینان شود که وجود خطاهای مشاهده در متغیرهای مستقل را در نظر می گیرد. [11] یک رویکرد جایگزین، برازش یک مدل با حداقل مجذورات کل است; این را می توان به عنوان اتخاذ یک رویکرد عمل گرایانه برای متعادل کردن اثرات منابع مختلف خطا در فرمول بندی یک تابع هدف برای استفاده در برازش مدل در نظر گرفت.

حل مسئله حداقل مربعات [ ویرایش ]

حداقل مجموع مربع ها با صفر کردن گرادیان به دست می آید . از آنجایی که مدل دارای پارامترهای m است، معادلات شیب m وجود دارد:

و از

معادلات گرادیان برای تمام مسایل حداقل مربعات اعمال می شود. هر مسئله خاص به عبارات خاصی برای مدل و مشتقات جزئی آن نیاز دارد. [12]

حداقل مربعات خطی [ ویرایش ]

مقاله اصلی: حداقل مربعات خطی

یک مدل رگرسیون زمانی خطی است که مدل ترکیبی خطی از پارامترها باشد، به عنوان مثال،

که در آن تابع

اجازه دادن

یافتن حداقل را می توان از طریق صفر کردن گرادیان ضرر و حل آن به دست آورد

در نهایت گرادیان از دست دادن را بر روی صفر قرار داده و برای را حل کنید

حداقل مربعات غیر خطی [ ویرایش ]

مقاله اصلی: حداقل مربعات غیر خطی

در برخی موارد، یک راه حل با شکل بسته برای مسئله حداقل مربعات غیرخطی وجود دارد - اما به طور کلی وجود ندارد. در صورت عدم پاسخ به شکل بسته، از الگوریتم های عددی برای یافتن مقدار پارامترها استفاده می شود.{\displaystyle \بتا }

که در آن بالانویس k یک عدد تکرار و بردار افزایش ها است

J Jacobian تابعی از ثابت ها، متغیر مستقل و پارامترها است، بنابراین از یک تکرار به تکرار دیگر تغییر می کند. باقی مانده توسط داده شده است

برای به حداقل رساندن مجموع مربع های

که در بازآرایی تبدیل به m معادلات خطی همزمان می شوند، معادلات عادی :

معادلات عادی به صورت نماد ماتریسی نوشته می شوند

اینها معادلات تعیین کننده الگوریتم گاوس-نیوتن هستند.

تفاوت بین حداقل مربعات خطی و غیرخطی [ ویرایش ]

- تابع مدل، f ، در LLSQ (حداقل مربعات خطی) ترکیبی خطی از پارامترهای فرم است.

این مدل ممکن است یک خط مستقیم، یک سهمی یا هر ترکیب خطی دیگری از توابع را نشان دهد. در NLLSQ (حداقل مربعات غیرخطی) پارامترها به عنوان توابع ظاهر می شوند، مانند

و غیره اگر مشتقات

یا ثابت هستند یا فقط به مقادیر متغیر مستقل بستگی دارند، مدل در پارامترها خطی است. در غیر این صورت مدل غیر خطی است.

- برای یافتن راه حل برای یک مشکل NLLSQ به مقادیر اولیه برای پارامترها نیاز دارید. LLSQ به آنها نیاز ندارد.

- الگوریتم های حل برای NLLSQ اغلب نیاز دارند که Jacobian را بتوان مشابه LLSQ محاسبه کرد. عبارات تحلیلی برای مشتقات جزئی می تواند پیچیده باشد. اگر عبارات تحلیلی به دست آوردن غیرممکن باشد، باید مشتقات جزئی را با تقریب عددی محاسبه کرد یا باید تخمینی از ژاکوبین انجام داد، اغلب از طریق تفاوت های محدود .

- عدم همگرایی (شکست الگوریتم در یافتن حداقل) یک پدیده رایج در NLLSQ است.

- LLSQ در سطح جهانی مقعر است، بنابراین عدم همگرایی مشکلی نیست.

- حل NLLSQ معمولاً یک فرآیند تکراری است که باید با برآورده شدن یک معیار همگرایی خاتمه یابد. راهحلهای LLSQ را میتوان با استفاده از روشهای مستقیم محاسبه کرد، اگرچه مسائل با تعداد زیادی پارامتر معمولاً با روشهای تکراری حل میشوند، مانند روش گاوس – سیدل .

- در LLSQ راه حل منحصر به فرد است، اما در NLLSQ ممکن است چندین حداقل در مجموع مربع ها وجود داشته باشد.

- تحت شرایطی که خطاها با متغیرهای پیشبینیکننده همبستگی ندارند، LLSQ تخمینهای بیطرفانه به دست میدهد، اما حتی تحت آن شرایط، تخمینهای NLLSQ عموماً بایاس هستند.

هر زمان که به دنبال راه حل برای یک مسئله حداقل مربعات غیرخطی هستیم، این تفاوت ها باید در نظر گرفته شوند. [12]

منبع

https://en.wikipedia.org/wiki/Least_squares

در این وبلاگ به ریاضیات و کاربردهای آن و تحقیقات در آنها پرداخته می شود. مطالب در این وبلاگ ترجمه سطحی و اولیه است و کامل نیست.در صورتی سوال یا نظری در زمینه ریاضیات دارید مطرح نمایید .در صورت امکان به آن می پردازم. من دوست دارم برای یافتن پاسخ به سوالات و حل پروژه های علمی با دیگران همکاری نمایم.در صورتی که شما هم بامن هم عقیده هستید با من تماس بگیرید.

در این وبلاگ به ریاضیات و کاربردهای آن و تحقیقات در آنها پرداخته می شود. مطالب در این وبلاگ ترجمه سطحی و اولیه است و کامل نیست.در صورتی سوال یا نظری در زمینه ریاضیات دارید مطرح نمایید .در صورت امکان به آن می پردازم. من دوست دارم برای یافتن پاسخ به سوالات و حل پروژه های علمی با دیگران همکاری نمایم.در صورتی که شما هم بامن هم عقیده هستید با من تماس بگیرید.